人工智能助力个性化职场导师:Practica的革命性服务

一天早晨,王大神在他的工作室里弹奏着优美的吉他曲目,享受着音乐的美妙。他的电脑屏幕上突然弹出一则新闻,题为《Practica:个性化职场导师的未来已来》。王大神立刻被这个标题吸引住了,因为他一直关注着人工...

一天早晨,王大神在他的工作室里弹奏着优美的吉他曲目,享受着音乐的美妙。他的电脑屏幕上突然弹出一则新闻,题为《Practica:个性化职场导师的未来已来》。王大神立刻被这个标题吸引住了,因为他一直关注着人工...

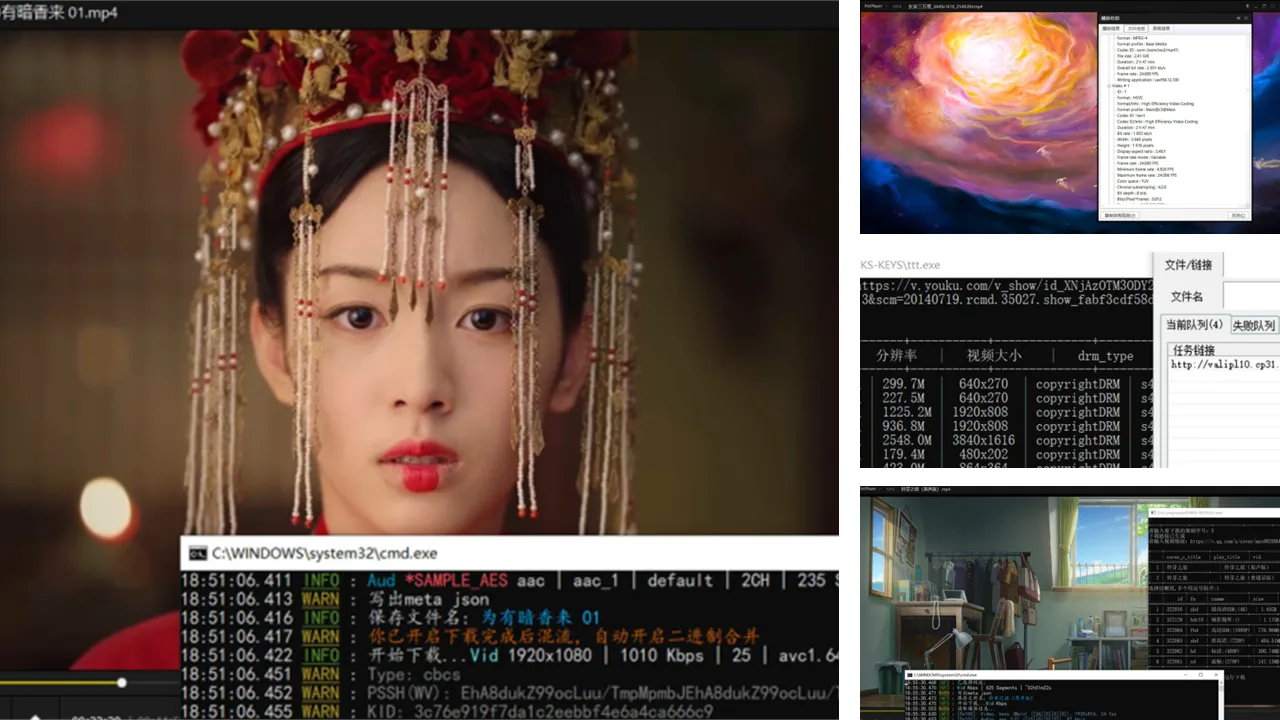

在这个数字时代,网络上有无数的视频内容等待着观众的欣赏。然而,有时我们想要在没有网络连接的情况下观看这些视频,或者想要将它们保存在我们的设备上,以备离线使用。这就是网页视频下载器的价值所在。今天,...

有一位名叫王大神的朋友,是一位狂热的电子设备爱好者和自由职业者。他每天的生活都充实而有序,兼顾了工作、娱乐和学习。而今天,我将站在王大神的角度,向大家介绍一场即将到来的绝佳机会——2023年双11大促活动...

在数字时代,文字编辑成为我们日常生活和工作不可或缺的一部分。无论是写博客、笔记、文章,还是编辑代码文档,一款强大而优雅的文本编辑器都能提高工作效率和写作愉悦度。今天,我们将为大家介绍一款备受推崇的 ...

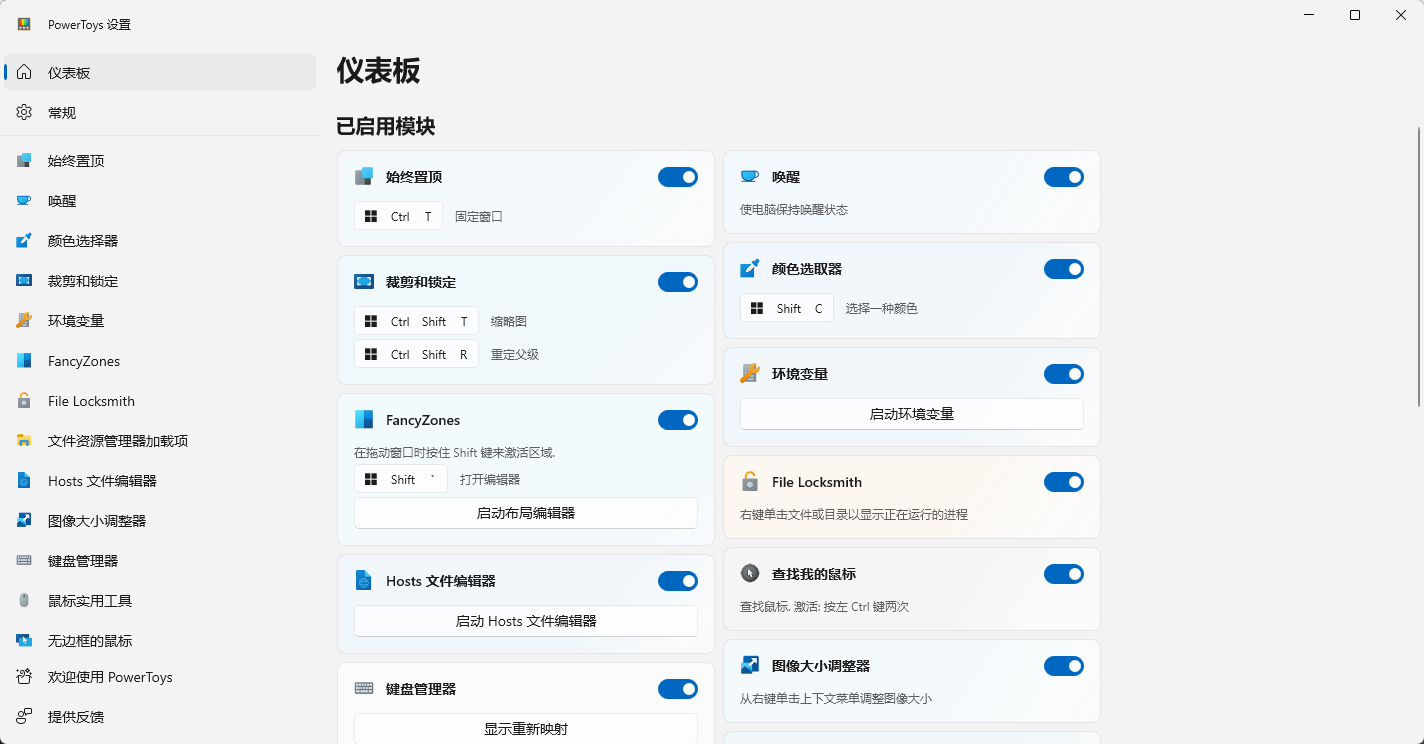

在一个寒冷的冬日,我正忙着处理工作中的各种文件。突然,我想起了曾经在微软的那段日子,那时的我总是在找寻能够提高工作效率的工具。当我无意中发现了 PowerToys,我的工作效率得到了质的飞跃。而今,微软已经...

“不行,这样下去公司会破产的!”我站在办公室窗前,看着手中的财务报告,心情沉重。最大的开支无疑来自编辑部门,他们负责公司网站上所有的内容创作和编辑。 在这个信息爆炸的时代,内容就是王道。但是,如何在保...

Linux内核一直是开源世界的中流砥柱,每个新版本的发布都引发着广泛的关注。如今,正如预期的那样,Linux之父Linus Torvalds刚刚发布了Linux 6.6稳定版内核,带来了一系列令人振奋的变革。本文将带您走进Linux 6....

王大神是一名热衷于网站管理和SEO优化的网站管理员。他一直在寻找一种工具,可以帮助他发现和解决网站上的技术性SEO问题,以提高网站在搜索引擎上的表现。某天,他听说了一个名为Site Scan的工具,可以对网站进行...

王大神是一位IT管理员,他的工作涉及管理多台Linux服务器和维护Active Directory(AD)域。一天,他面临了一个挑战:将他的Linux服务器无缝地加入AD域,以实现更好的用户管理和权限控制。这听起来似乎是一个复杂...

有一天,王大神在互联网上听说了一个神奇的数字支付平台,名叫Duapy(原DePay)。他被Duapy的去中心化特性所吸引,想要尝试使用它来支付和兑换他的数字资产。但是,他发现在Duapy上进行支付和兑换之前,需要先进...

有一天,你突然醒来,感觉自己刚刚经历了一场充满冒险和神秘感的梦境。你试图回忆起那个梦境的片段,但随着时间的推移,它似乎越来越模糊。然而,有时候,梦境中的一些情节或场景却在你的现实生活中出现,让你感...

有一天,小明突然想要找到一些高清的4K视频和杜比视界的资源,以享受更高质量的观影体验。他听说115盘可能是一个不错的资源来源,但他不知道如何开始搜索和获取这些资源。于是,他决定求助于网络大佬们,希望他们...

有一天,小明想要玩他最喜欢的在线游戏CS:GO,但他的电脑似乎总是优先使用有线网络,而不是更快的无线网络。他尝试了各种方法,但微信聊天记录的迁移问题也在困扰着他。幸运的是,小明找到了一个解决方案,让他的...

故事从一位名叫王大神的程序员开始。他一直在寻找一种方式来自动化一些日常任务,特别是一些需要每天定期执行的签到任务。这让他产生了一个想法:创建一个工具,可以方便地管理和运行各种签到脚本。这个想法最终...

有一位朋友,曾经在两个月内复习成功考上了中山大学,虽然总共要参加五门考试,但他只考取了第八名。在面试环节中,还有两个考生被淘汰,还有一个因为自费而放弃了。这位朋友的经历告诉我们,考研虽然困难,但也...

去年冬天,我在推特上发了一条自认为惊世骇俗的推文,配图精美,文案打磨了四十分钟。发出去之后,我每隔五分钟刷新一次,期待点赞像潮水般涌来。

结果到了晚上,点赞数是1——点开一看,是我自己。

那一刻我突然明白,在这个信息爆炸的时代,你说了什么不重要,重要的是有没有人听到你说。

后来我学会了一招,叫"评论卡位"。现在我每天花十分钟,比发一百条推文都管用。

我曾经以为,只要内容足够好,粉丝自然会来。

这个想法很美好,美好得就像相信努力就一定有回报、相信好人一生平安一样天真。

事实是这样的:在Twitter上,你发一条推文,平均阅读量大概是你粉丝数的10%左右。如果你只有100个粉丝,那么你的推文大概会被10个人看到。这10个人里,可能有5个是机器人,3个是僵尸粉,剩下2个正在刷别的内容。

你精心准备的内容,很可能从出生到死亡,全程只有你自己在围观。

这不是你的内容不好,这是冷启动的困境。

就像一个新开的餐厅,哪怕厨师是米其林三星级别,如果开在一条没人走的巷子里,照样门可罗雀。

让我们做一道简单的数学题。

假设你是一个刚注册的新账号,粉丝数为0。你每天发3条推文,每条推文的自然曝光量约为50次(这已经算乐观估计了)。

| 时间周期 | 发帖数量 | 总曝光量 | 预计新增粉丝 |

|---|---|---|---|

| 1周 | 21条 | 1,050次 | 0-5人 |

| 1个月 | 90条 | 4,500次 | 5-20人 |

| 3个月 | 270条 | 13,500次 | 20-80人 |

三个月发270条推文,换来80个粉丝。

这个投入产出比,比我大学时追女生的成功率还低。

但是,有一个地方的流量是免费的、巨大的、而且几乎没人在认真争抢——

评论区。

你有没有注意过,那些动辄10万阅读的热门推文,评论区热闹得像菜市场。有些评论能收获上百个点赞,几千人围观。

这些评论的作者,可能只有几百个粉丝,但他们的一条评论,比他们自己发一百条推文的曝光量都多。

发帖是自己造飞机,评论是搭别人的顺风机。

道理很简单:你不需要自己拥有流量,你只需要出现在流量聚集的地方。

一条主推如果获得了10万阅读,排在前面的评论通常能获得这个数字的1/10左右的曝光——也就是说,你的一条评论可能被1万人看到。

对于一个冷启动的账号来说,你发100条普通推文可能都达不到这个曝光量。

这就是评论卡位的魔力。

很多人以为评论区是平等的,先到先得,大家排队。

错了。

Twitter的评论区有一套复杂的排序机制,决定了哪些评论被顶到最上面,哪些评论被埋在最底下。

这个机制考虑的因素包括但不限于:

其中,时间是最关键的因素。

一条早期发布的评论,即使内容一般,也比一条晚到的精彩评论更容易获得靠前的位置。因为它有更多时间积累点赞,而点赞又会进一步巩固它的位置。

这是一个马太效应:早期的优势会不断被放大。

绝大多数爆款推文的生命周期,可以用一条曲线来描述:慢启动、快爆发、缓衰减。

Twitter的算法是这样工作的:

这意味着什么?

你必须在推文发布后的前2小时内完成评论卡位。

如果你在一条推文已经火了之后才去评论,你的评论会被埋在几十甚至上百条评论之后,根本没人能看到。

这就像抢火车票——你不是和那条推文比赛,你是和其他想卡位的人比赛。

有人可能会问:那我怎么知道哪条推文会火呢?

答案是:你不需要知道,你只需要提高概率。

大V的帖子不一定条条都火,但他们的"起爆概率"比普通人高很多。原因很简单:

| 对比维度 | 大V账号 | 普通账号 |

|---|---|---|

| 基础粉丝量 | 10万+ | 100-1000 |

| 平均帖子阅读量 | 5万+ | 50-500 |

| 算法权重 | 高 | 低 |

| 内容被推荐概率 | 高 | 低 |

| 粉丝活跃度 | 高 | 不稳定 |

大V发的帖子,哪怕内容平平,也有基础的曝光量保底。一旦内容稍微带点话题性,就很容易被算法推上热门。

所以,聪明的做法是给多个大V设置推送提醒。他们一发帖,你就第一时间冲进去评论。

这种策略叫:广撒网,卡位抢船票。

你不需要每次都押中,你只需要偶尔押中一次,就能获得巨大的曝光。

大多数人用Twitter的方式是:打开首页,刷信息流,看到什么算什么。

这就像去图书馆不用目录,靠随机游走找书一样低效。

Twitter其实是一个巨大的数据库,你可以用高级搜索语法精确检索任何你想要的内容。

让我教你几个最实用的搜索技巧:

"AI tools"加引号表示精确搜索这个短语。不加引号的话,系统会把"AI"和"tools"分开匹配。

from:@levelsio只看某个账号发布的推文。这个语法对于监控特定大V非常有用。

min_faves:50只显示点赞数超过50的推文。这是筛选"有潜力"帖子的利器。

since:2025-01-15 until:2025-01-17只显示特定时间段内的推文。

lang:en

lang:zh限制搜索结果的语言。如果你做英文内容,建议默认加上lang:en。

学会了基础语法,接下来是实战组合。

第一板斧:话题关键词组合搜索

这是用来发现正在升温的领域热帖的方法。

比如你关注AI工具领域,可以这样搜索:

"AI tools" min_faves:30 lang:en since:2025-01-16这条语法的意思是:搜索过去24小时内,包含"AI tools"这个关键词的英文推文,且点赞数超过30。

你可以根据自己的领域,准备几组常用的关键词组合:

| 领域 | 推荐关键词组合 |

|---|---|

| AI/科技 | "AI tools"、"ChatGPT"、"just launched"、"new feature" |

| 独立开发 | "build in public"、"indie hacker"、"side project"、"MRR" |

| 创业 | "startup"、"funding"、"pivot"、"lessons learned" |

| 个人品牌 | "personal branding"、"growth tips"、"followers" |

| 加密货币 | "crypto"、"Bitcoin"、"DeFi"、"web3" |

第二板斧:大V账号追踪法

这是用来直接盯人的方法。

假设你关注了10个领域内的大V,可以用这样的语法一次性监控他们:

(from:user1 OR from:user2 OR from:user3 OR from:user4 OR from:user5) min_faves:10 since:2025-01-16把user1到user5替换成你要监控的大V账号名,就能看到他们最近发布的、已经开始有互动的帖子。

这招的精髓在于:你不是等帖子火了才看到,而是在帖子刚开始"冒烟"的时候就发现了。

搜索出来一堆帖子,怎么判断哪些值得下注?

这里有一个快速检查清单:

| 检查项 | 加分项 | 减分项 |

|---|---|---|

| 发布时间 | 2小时以内 ✅ | 超过6小时 ❌ |

| 点赞速度 | 20分钟50赞 ✅ | 2小时才10赞 ❌ |

| 内容形式 | 图文/数据/故事 ✅ | 纯链接/纯文字 ❌ |

| 情绪价值 | 有冲突/有共鸣/有干货 ✅ | 平淡无奇 ❌ |

| 评论区 | 还比较空(<20条)✅ | 已经很热闹(>100条)❌ |

| 作者粉丝量 | 1万以上 ✅ | 100以下 ⚠️ |

记住一个口诀:"小爆蹲30,大爆抢10"

根据我的观察,以下几类内容最容易起爆:

1. 数字型成就

"刚刚达成了100个付费用户" "我的SaaS月收入突破1万美元了" "写了30天,涨了5000粉"

人类对数字有天然的敏感,尤其是里程碑式的数字。

2. 反直觉型观点

"我放弃了10万年薪的工作,现在每天赚得更多" "停止发帖之后,我的粉丝反而涨得更快了"

这类内容制造认知冲突,让人忍不住想点开看看。

3. 情绪宣泄型

"创业三年,我终于明白了这些残酷的真相" "被拒绝了50次之后,我想说……"

能引发共鸣的情绪内容,转发率特别高。

4. 实用干货型

"我总结了10个免费的AI工具,每个都亲测好用" "这是我用ChatGPT提高效率的完整流程"

能帮别人解决问题的内容,永远有市场。

5. 行业内幕型

"在XX公司工作三年,说几个你不知道的事" "投资人不会告诉你的5个真相"

人们总是对"内幕"充满好奇。

找到了值得卡位的帖子,接下来是最关键的一步:写评论。

评论大致可以分为三个层次:

第一层:无效评论

"厉害"

"大佬牛逼"

"学习了"

"👍👍👍"这类评论约等于没评。它既不提供价值,也不会给你带来任何关注。发这种评论的人,大概率是懒得动脑子,又想刷存在感。

第二层:普通评论

"这个观点很有启发,之前没想到这个角度"

"我也遇到过类似的问题,感同身受"

"请问你用的是什么工具?"这类评论比第一层好一些,至少表达了真实的想法。但它仍然不够出众,很难吸引别人点击你的主页。

第三层:高质量评论

"作为同样在做独立开发的人,我完全理解从0到100用户的艰难。

我的经验是,前20个用户最难,之后会越来越快。

好奇问一下:你的前20个用户是怎么获取的?

(顺便说一句,我正在做一个类似方向的项目,已经关注你了!)"这类评论有几个特点:

根据我的总结,一条高质量评论通常包含以下要素:

共鸣 + 价值 + 互动 + 软性推广

让我用几个模板来说明:

模板一:感同身受型

Wow, totally feel this.

I went through a similar phase when [简述你的相关经历].

What helped me was [你的建议或经验] — might be worth trying?

Following your journey!模板二:请教探讨型

This is 🔥

Quick question — did you [相关问题] manually or with some tools?

I'm exploring something similar, would love to learn more.模板三:补充价值型

Great point!

One thing I'd add is [你的补充观点或数据].

I've been tracking this for a while and found that [你的发现].模板四:顺势引流型

This hits hard.

I actually built a [你的产品/项目类型] to solve this exact thing.

Just shipped the beta last week — early feedback would be super helpful!1. 不要当复读机

最忌讳的评论方式是重复主帖的内容。比如人家说"我今天达成了100个用户",你评论"恭喜达成100个用户"——这不叫评论,这叫复读。

2. 不要硬广

❌ "好文章!顺便推荐一下我的产品xxx,现在注册有优惠!"这种评论不仅不会给你带粉,还会让人反感,甚至可能被举报为垃圾信息。

3. 要像聊天,不像写文章

评论区是社交场景,不是发表论文的地方。用口语化的表达,加点emoji,让人觉得你是一个真人,而不是一个营销机器。

4. 第一人称很重要

用"我"开头的句子比用"这个"开头的句子更有亲和力。

✅ "I've been struggling with the same problem..."

❌ "This is a common problem that many people face..."5. 问一个好问题

一个好问题比一堆赞美更有价值。它不仅能引发对话,还能展示你的思考深度。

评论的最终目的是什么?是让看到评论的人产生好奇,点击你的主页,然后关注你。

所以,在评论中巧妙地介绍自己正在做什么,是完全可以的——前提是要自然,不要生硬。

自然的方式:

"作为一个同样在做AI工具的独立开发者,我特别理解这种感觉..."

"我正在研究类似的方向,你的这个思路给了我很大启发..."

"我的newsletter上周也写了这个话题,评论区的讨论特别热烈..."生硬的方式:

"说得太对了!另外,欢迎关注我的账号,我也分享很多干货!"

"好文章!顺便说一下我也在做xxx,有兴趣的可以看看我主页!"区别在哪?

自然的方式是顺着话题说,让你做的事情成为语境的一部分; 生硬的方式是强行转场,让人明显感觉到你在打广告。

到目前为止,你已经学会了:

但如果你只是偶尔想起来才去做,效果会大打折扣。

真正的高手,会把这件事变成一套可重复执行的系统。

就像刷牙一样——你不需要每天早上思考"今天要不要刷牙",你只需要按时执行既定动作。

我建议你把评论卡位分成几个固定的时间段:

| 时间段 | 动作 | 时长 |

|---|---|---|

| 早上8:30 | 第一轮搜索+评论 | 10分钟 |

| 中午12:30 | 第二轮搜索+评论 | 10分钟 |

| 下午17:00 | 第三轮搜索+评论 | 10分钟 |

| 晚上21:00 | 复盘+主页优化 | 15分钟 |

每天总共不到1小时,但这1小时的投入产出比,远超你花3小时发自己的推文。

为什么要分成多个时间段?

因为好的推文在一天中的任何时间都可能出现。如果你只在早上看一次,可能会错过下午爆发的帖子。

分散成多个时间段,可以让你覆盖更多的机会窗口。

第一条线:关键词搜索

准备3-5组你领域内的常用关键词组合,每天轮换使用。

比如你做AI领域:

"AI tools" min_faves:30 lang:en since:最近日期"ChatGPT" min_faves:50 lang:en since:最近日期"just launched" AI min_faves:20 lang:en since:最近日期第二条线:大V监控

挑选5-10个你领域内的中大V,把他们的账号名做成一个搜索语法:

(from:user1 OR from:user2 OR from:user3 OR from:user4 OR from:user5 OR from:user6 OR from:user7 OR from:user8 OR from:user9 OR from:user10) min_faves:10 since:最近日期同时,对最重要的3-5个大V开启推送提醒。他们一发帖,你就第一时间收到通知。

为了提高效率,你可以提前准备一个评论模板库,根据不同类型的帖子选用不同的模板。

成就类帖子(达成xx用户、收入突破xx)

Huge congrats! 🎉

This is exactly the milestone that separates hobbyists from real builders.

Curious — what was the turning point that got you from [小数字] to [当前数字]?

Following closely!干货类帖子(总结了xx条经验、分享xx工具)

This is gold 🔥

Bookmarked for later reference.

One thing I'd add based on my experience: [你的补充]

Thanks for putting this together!求助类帖子(遇到xx问题、不知道怎么选择)

Been there.

What worked for me was [你的建议].

Happy to share more details if helpful — DM is open!争议类帖子(某个有争议的观点)

Interesting take.

I see your point, but I think there's also [另一个角度].

Would love to hear your thoughts on [一个好问题]?故事类帖子(分享个人经历、失败教训)

Thanks for sharing this so openly.

Stories like this are what make this platform valuable — real lessons from real experience.

One thing that resonated with me: [你的共鸣点]这是很多人忽略的一步,但它非常重要。

你需要建立一个简单的记录系统,追踪你的评论效果:

| 日期 | 评论的帖子 | 评论内容摘要 | 评论点赞数 | 主页访问 | 新增粉丝 |

|---|---|---|---|---|---|

| 1/15 | @xxx的AI工具帖 | 分享了我的使用经验 | 23 | 45 | 8 |

| 1/15 | @yyy的创业故事 | 提了一个问题 | 5 | 12 | 2 |

| 1/16 | @zzz的数据分享 | 补充了我的数据 | 56 | 89 | 15 |

坚持记录一个月,你就能发现:

然后根据这些数据调整你的策略。

在实践过程中,有几个常见的坑需要避免:

坑1:评论太频繁被判定为spam

如果你在短时间内评论了太多帖子,Twitter可能会把你判定为垃圾账号,限制你的曝光甚至封号。

建议:每小时评论不超过5条,每天总评论不超过20条。

坑2:只评论不互动

如果有人回复了你的评论,一定要回复。这不仅能增加你评论的热度,还能建立真实的社交关系。

坑3:评论与主页人设不符

如果你的评论风格和主页内容差距太大,别人点进来会觉得很奇怪。

建议:保持一致的人设,让评论成为你主页内容的延伸。

坑4:只蹲大V,忽略中小V

大V的帖子竞争激烈,你的评论很可能被淹没。中小V(粉丝1-5万)的帖子竞争小,而且他们往往更愿意与评论者互动。

建议:大V和中小V的帖子都要关注,找到适合自己的平衡点。

评论卡位的最高境界,不是为了曝光,而是为了建立关系。

当你持续在某个人的帖子下发表高质量评论,对方会注意到你。久而久之,你们可能会互相关注,甚至成为朋友。

我认识的很多人,他们最初的人脉网络都是通过评论区建立的。

评论不只是引流手段,更是社交敲门砖。

最佳评论时机

最差评论时机

当你打开一条帖子的评论区时,先花10秒钟扫一眼现有的评论:

评论区也是红海和蓝海之分。

有一种高级玩法是:故意写一个有争议的评论,引发讨论。

比如帖子说"AI会取代程序员",你可以评论"我觉得AI更可能先取代的是设计师,程序员反而是最后一批"。

这种评论会引来各种回复,而每一条回复都会增加你评论的热度,让更多人看到你。

当然,这种玩法需要谨慎使用,不要为了引战而引战。

如果你有明确的引流目标,可以在评论中加入温和的call to action:

"I write about this topic every week in my newsletter — feel free to check it out!"

"I'm building something similar — would love to connect and exchange notes."

"If anyone wants to discuss this further, my DMs are open."这些都是不那么硬的推广方式,给感兴趣的人一个行动的理由。

虽然本文主要讲Twitter,但评论卡位的思路在其他平台也适用,只是细节有所不同:

| 平台 | 评论排序逻辑 | 最佳策略 |

|---|---|---|

| Twitter/X | 时间+互动 | 抢早期位置 |

| 互动+关系 | 评论大V,建立连接 | |

| YouTube | 点赞数为主 | 写能引发共鸣的评论 |

| 小红书 | 时间+互动 | 关注最近几小时的热帖 |

| 即刻 | 时间为主 | 抢早期评论 |

不管在哪个平台,核心逻辑是一样的:找到流量聚集的地方,输出有价值的内容,吸引注意力。

会。Twitter的评论排序主要看时间和互动,账号权重的影响没有那么大。只要你评论得早、评论内容好,就有机会被排在前面。

取决于你的目标受众。如果你想做英文账号,就用英文评论英文帖子;如果你想做中文账号,就用中文评论中文帖子。不建议混着来,这会让你的人设很混乱。

Twitter有时会折叠它认为"低质量"的评论。如果你的评论经常被折叠,检查一下:

改进内容质量通常能解决这个问题。

30-60分钟。分成几个时间段,每次10-15分钟。如果你时间更多,可以做得更多;如果时间紧张,每天2-3条高质量评论也能见效果。

因人而异。有的人第一周就能涨几十粉,有的人需要坚持一个月才能看到明显变化。关键是保持持续和稳定,不要指望一夜暴富。

取决于你的评论质量。如果你只是发"好厉害"这种废话,确实是在蹭热度。但如果你提供了真正的价值、有趣的观点或有用的补充,那就是正常的社交互动。

Twitter本来就是一个公开讨论的平台,评论区的互动是平台鼓励的行为。

有一些AI工具可以帮助你:

但工具只是辅助,最重要的还是你的判断力和写作能力。

让我用一个真实的案例来说明评论卡位的效果。

去年10月,我注册了一个新的Twitter账号,专注于分享AI工具使用心得。起步时粉丝为0,面临典型的冷启动困境。

我采用了本文介绍的评论卡位策略:

第一周

重点在于熟悉节奏。我花了很多时间学习如何判断"有爆相"的帖子,也踩了不少坑(比如评论了很多最后没爆的帖子)。

| 指标 | 数据 |

|---|---|

| 评论数 | 42条 |

| 获得点赞的评论 | 15条 |

| 评论总点赞 | 87个 |

| 新增粉丝 | 23人 |

第二周

开始找到感觉,能更准确地判断哪些帖子值得评论。

| 指标 | 数据 |

|---|---|

| 评论数 | 38条 |

| 获得点赞的评论 | 22条 |

| 评论总点赞 | 156个 |

| 新增粉丝 | 45人 |

第三周

有一条评论意外爆了——在一条10万阅读的帖子下,我的评论获得了180个点赞,直接带来了200多个新粉丝。

| 指标 | 数据 |

|---|---|

| 评论数 | 35条 |

| 获得点赞的评论 | 25条 |

| 评论总点赞 | 340个 |

| 新增粉丝 | 230人 |

第四周

持续稳定输出,同时开始增加原创帖子的比重。

| 指标 | 数据 |

|---|---|

| 评论数 | 30条 |

| 获得点赞的评论 | 20条 |

| 评论总点赞 | 195个 |

| 新增粉丝 | 85人 |

| 指标 | 起点 | 一个月后 |

|---|---|---|

| 粉丝数 | 0 | 383 |

| 发帖数 | 0 | 15 |

| 评论数 | 0 | 145 |

| 总曝光量 | 0 | 约50万 |

重要发现:

什么有效:

什么无效:

写这篇文章的时候,我想起了刚开始玩Twitter的自己——那个发了半小时精心打磨的推文,最后只收获1个点赞(还是自己点的)的傻瓜。

后来我明白了一个道理:在流量的游戏里,位置比内容更重要。

你可以是最好的厨师,但如果餐厅开在没人的巷子里,照样没人吃。

你可以写出最好的内容,但如果没人看到,内容再好也没用。

评论卡位,本质上是一种"借势"的智慧。

你借用别人已经建立的流量池,在别人的舞台上展示自己。这不是蹭热度,这是聪明地利用资源。

当然,评论卡位只是冷启动的一种方法,不是全部。当你的账号有了一定基础之后,你还是需要持续输出高质量的原创内容。

但在起步阶段,这可能是最有效的增长方式之一。

最后,送你一句话:

别等着被发现,去到能被发现的地方。

祝你评论区战绩辉煌 🎯

本文要点速览

现在,打开Twitter,找一条即将起飞的推文,写下你的第一条高质量评论吧。

别让干货只停留在阅读,动手干,才是真的有用 💪

去年冬天,一个做知识付费的朋友请我吃饭。他在2021年卖课赚了两百多万,去年勉强保本。火锅还没煮开,他就问我:"你说我是不是该转行了?"

我说你先把肉放下去。

他没听,继续说:"现在谁还买课啊,ChatGPT什么都能教。"

我看着锅里翻滚的泡沫,觉得这个比喻很贴切——很多人以为知识付费已经沸腾到尽头了,其实锅底的火还没熄,只是需要换一种烧法。

2026年刚开年,我的信息流里充斥着各种"已死"宣言。

价值内容已死。 信息产品已死。 教练咨询已死。 个人品牌已死。

说得好像互联网上正在进行一场大规模的殡葬活动,每个人都在争着给各种商业模式写悼词。

这让我想起2010年前后,所有人都在说博客已死、论坛已死、门户网站已死。然后呢?博客变成了公众号,论坛变成了社群,门户网站变成了信息流。死的只是形式,活着的是人们获取信息的需求。

但我理解为什么大家都在喊"已死"——因为旧的打法确实不灵了。

你还记得2019年到2023年那段时间吗?那时候做知识付费简直是躺着赚钱:

这套模式简单粗暴,但它有效。有效到让无数人涌入这个赛道,有效到让"知识付费"这四个字从一种商业模式变成了一种流行病。

然后,流行病遇到了它的天敌——市场饱和。

有个叫尤金·施瓦茨的老头,是上世纪的传奇广告文案大师。他提出了一个理论,叫做市场成熟度五阶段:

| 阶段 | 特征 | 你需要做什么 |

|---|---|---|

| 第一阶段 | 市场是空白的 | 直接说你的产品能做什么 |

| 第二阶段 | 竞争者出现 | 你需要喊得比别人更大声 |

| 第三阶段 | 市场开始怀疑 | 你需要解释你为什么能做到 |

| 第四阶段 | 机制被复制 | 你需要更独特的卖点 |

| 第五阶段 | 所有人都疲了 | 品牌和信任成为唯一的筹码 |

知识付费行业,毫无疑问已经走到了第五阶段。

"我能教你月入十万" ——听起来像骗子。 "我用独创的两小时内容矩阵系统帮你实现月入十万" ——听起来像高级骗子。 "加入我的社群,和一群志同道合的人一起成长" ——听起来像...还是骗子。

不是你在骗人,是整个市场已经被骗怕了。😅

当每个人都在用同样的话术、同样的套路、同样的模版时,消费者最聪明的选择就是谁都不信。

这就是为什么"价值内容已死"——不是价值死了,是包装价值的方式死了。

在继续之前,我想先聊聊"一人公司"到底是什么。

一人公司不是说你只能一个人干活,而是说整个商业闭环可以由一个人完成。你一个人就是:

这在互联网出现之前是不可想象的。那时候,你想卖东西必须有店面、有员工、有供应链。一个人能做的生意,也就是在街边摆个摊。

但互联网改变了一切。

你用内容获取流量——不需要租金。 你用兴趣定义专业——不需要学历。 你用产品变现价值——不需要库存。

这个基本原理过去十年没变,未来十年也不会变。变的只是具体的执行方式。

以前你可能是做一本电子书,现在可能是做一个Notion模版。 以前你可能是录一套网课,现在可能是建一个AI助手。 以前你可能是开一个训练营,现在可能是开发一个小工具。

容器在变,装的东西没变。

人们依然想学习,依然想成长,依然愿意为能解决问题的东西付费。问题是:什么样的"容器"能让他们愿意掏钱?

让我先说清楚一件事:我不认为信息产品是骗局。

恰恰相反,我认为好的信息产品是传统教育的解药。传统教育教你服从、教你找工作、教你接受现有的一切。而信息产品教你创造、教你独立、教你质疑。

但是——

从来没有哪个时代,制作一个平庸的信息产品像现在这么简单。

你可以让AI在两小时内生成一本电子书。 你可以让AI帮你写完一整套课程大纲。 你可以让AI设计封面、写文案、甚至回复客户。

这听起来很美好,直到你意识到:每个人都能这么干。

当制作门槛降到接近于零时,市场上就会充斥着大量廉价、同质化的产品。消费者面对满屏的"7天学会XXX"和"从零到一掌握XXX",本能反应就是全部忽略。

这就是信息产品正在死去的原因——不是因为没人愿意学习,而是因为静态的、单向的、一次性的内容形式,已经无法在注意力极度稀缺的时代生存。

想想看:

不是产品不好,是产品形式本身就有问题。

如果你回顾人类历史,你会发现一个有趣的规律:

最有效的学习从来都不是坐着听课。

在大规模教育出现之前,知识是怎么传承的?师徒制。

一个铁匠不会给学徒一本《打铁100讲》,然后说:"看完了你就会了。"

他会站在学徒身边,看着他挥锤,纠正他的姿势,指出他的错误,在他做对时给予肯定。学徒不是在"学习打铁的知识",而是在打铁的过程中学习。

这就是所谓的"learning by doing"——边做边学。

但后来呢?工业革命来了,社会需要快速培养大量劳动力。于是我们发明了学校:

这套系统非常适合批量生产"合格的工人",但它在培养真正的能力方面,效率低得可怕。

而现在,我们第一次有机会在规模化的同时,实现个性化。

AI就是那个可以站在每个人身边的"师傅"。它可以:

这不是科幻,这是现在就能实现的事情。

让我给你描述一个场景。

假设你想学习写作,传统的信息产品是这样的:

成功率:5%

而未来的教育产品应该是这样的:

成功率:50%以上

看到区别了吗?

第一种模式是"我给你知识,你自己消化"。 第二种模式是"我陪你练习,你边做边学"。

前者像是给你一本菜谱,后者像是有个厨师站在你旁边手把手教你做菜。

哪种更有效?不言而喻。

我知道很多人对AI有天然的抵触情绪。

"AI会让人变懒。" "AI会取代人类。" "AI会让一切变得没有意义。"

这些担忧我理解,但我想说:这取决于你怎么用它。

AI可以是替你做一切的工具——然后你确实会变懒,会失去技能,会感到空虚。

AI也可以是帮你学习的伙伴——然后你会成长得更快,掌握得更多,创造得更好。

这就像锤子可以用来建房子,也可以用来砸人。工具是中性的,意图不是。

而且有趣的是,AI辅助学习并不是什么新发明。它本质上是师徒制的回归。

几千年来,人类最有效的学习方式就是跟着一个有经验的人边干边学。工业化教育只是一个特殊时期的特殊产物——因为我们没有足够的"师傅"来教每一个人。

但现在,AI可以扮演那个角色。

我们不是在走向一个冰冷的机器时代,我们是在用新技术回归最古老的智慧。

这就是我说的"手艺人的复兴"——每个人都可以有一个专属的导师,引导自己成为某个领域的手艺人。

说了这么多理论,现在让我们来点实际的。

如果你是一个想在2026年做一人公司的人,你应该怎么把"信息产品"升级为"学习体验"?

不要把课程想象成"一套视频",把它想象成一个AI可以查询的数据库。

你依然需要把自己的知识整理出来——方法论、框架、案例、步骤。但整理的目的不是让用户去看,而是让AI去理解。

这就像你为公司写了一套帮助文档,客服(AI)可以随时从里面找到答案来回应用户的问题。

传统课程有大纲:第一章、第二章、第三章...

新的学习体验需要的是提示词(System Prompt)。

提示词是你给AI的"人设说明书":

| 维度 | 内容 |

|---|---|

| 角色定义 | AI应该扮演什么角色?一个严厉的教练还是温和的导师? |

| 行为规则 | AI应该怎么和用户互动?先问问题还是直接给建议? |

| 知识边界 | AI应该基于哪些内容回答?你的框架还是通用知识? |

| 语气风格 | AI说话应该是什么调调?正式、幽默、还是犀利? |

一个好的提示词,就是你把自己"注入"到AI里的方式。

用户虽然是在和AI对话,但AI说的话、教的方法、用的框架,全都是你的。

这就是"卖你的第二大脑"的意思——你的脑子被复制了一份,可以同时教成千上万个人。 🧠

传统课程的结构是:

第一章:什么是写作

第二章:写作的基本方法

第三章:如何找到选题

...而学习体验的结构应该是:

模块一:学习(Learn)

→ AI引导用户理解核心概念

模块二:练习(Practice)

→ AI出题,用户做题,AI批改

模块三:创作(Create)

→ 用户完成一个真实的作品,AI全程辅助区别在于:传统课程的输出是"看完了",学习体验的输出是"做完了"。

用户结束一个学习体验时,手里应该有一个实实在在的东西:一篇文章、一份计划、一个项目、一套方案。

不是"我学了",而是"我会了"。

问:这不就是做软件吗?我不会编程怎么办?

这是个好问题。

首先,现在"编程"的门槛已经和三年前完全不同了。有了Cursor、Replit、Claude Code这些工具,你不需要精通代码,只需要能够描述你想要什么。

其次,我们说的"软件"并不是什么复杂的东西。它可能就是:

这种级别的东西,认真学习一两周是可以做出来的。

当然,你第一个做出来的版本肯定很丑、很难用、bug一堆。

但那有什么关系呢?你的第三个版本会好一些,第五个版本会更好。学任何东西都是这样。

问:那别人不会抄吗?

会。

但这不是不做的理由。因为:

问:这种东西能卖多少钱?

取决于你解决的问题值多少钱。

一个帮人学写朋友圈文案的AI助手,可能卖99一个月。 一个帮人准备面试的AI教练,可能卖299一个月。 一个帮企业培训销售团队的AI系统,可能卖几千一个月。

价格永远不取决于成本,而取决于价值。

我在开头说过,这套打法可能只有两到三年的有效期。为什么?

因为变化会越来越快。

信息产品这个模式,从兴起到饱和,用了大约10-15年。 AI辅助学习体验这个模式,从现在开始算,可能3-5年就会饱和。

到时候又会出现新的东西。

但这不是坏消息。

这恰恰说明了一人公司最大的优势:敏捷。

大公司有一百个员工、五十个项目、二十个会议,想转型需要一年。而你呢?明天就可以开始学新东西,下周就可以做新尝试。

唯一能保护你的,不是某个商业模式,而是你持续学习和适应的能力。

这话听起来像鸡汤,但它是事实。

我见过太多人把希望寄托在"找到一个长期稳定的赚钱方式"上。对不起,这种东西不存在。你的父母那一代可能能在一家公司干一辈子,你这一代不行。

变化才是常态,适应才是能力。

现在让我告诉你,在这个AI什么都能干的时代,你真正的竞争力是什么。

不是你会用什么工具——工具人人都能学。 不是你有什么方法——方法人人都能抄。 不是你认识什么人——人脉是最不可靠的资产。

你真正的竞争力,是你会用AI做什么别人想不到的事情。

Naval Ravikant管这个叫"Specific Knowledge"(特定知识):

"特定知识无法被培训,它来自于追随真正的好奇心。建立它会像玩耍一样让你享受。它通常处于知识的边缘。"

让我翻译成人话:

AI是放大器,不是创造者。

一个研究效率十年的人,用AI做出来的效率工具,和一个刚入门的人做出来的,完全不是一个东西。

一个写了一百万字的人,调教出来的写作AI,和一个刚开始写作的人调教出来的,天差地别。

你不需要比AI更聪明,你需要有AI没有的——人生。

说了这么多,让我给你一些可以立即开始的事情:

问自己:

把这些东西写下来。不用写成课程,先写成笔记、框架、清单。这就是你未来产品的"原材料"。

不需要成为专家,但至少要会:

这些技能,认真学的话两周到一个月可以入门。

不要想着一步到位做出完美的东西。先做一个最简单的版本:

让几个人试用,收集反馈,然后迭代。

永远不要在想象中完善产品,要在使用中完善产品。

产品再好,没人知道也没用。

在你学习新技能的同时,别忘了持续在社交媒体上分享你的思考和进展。这不仅是获取潜在用户的方式,也是逼迫自己持续学习的方式。

分享你的学习过程本身就是内容。人们喜欢看"普通人成长"的故事,而不是"大神教你做人"的说教。

在过去一年里,我注意到几件有意思的事:

第一,大多数人依然把AI当搜索引擎用。 🔍

问一个问题,得到一个答案,完事。他们没有意识到AI可以是一个助手、一个教练、一个合作者。

这意味着,如果你能把AI用得更深入,你就已经领先了90%的人。

第二,最难的不是技术,是想法。

技术门槛在快速降低,但"用AI做什么"这个问题,依然需要人来回答。

最有价值的能力不是"会用AI",而是"知道用AI做什么"。

第三,速度成了最重要的变量。

以前你可能有一年时间来打磨产品,现在你可能只有几个月。等你想清楚了再动手,机会已经没了。

边想边做、边做边学、边学边改——这是唯一可行的策略。

第四,"原创"的半衰期在缩短。 ⏰

你今天有一个好想法,发在网上,三天之后就有人在复制。一个月之后,它已经变成了"大家都在说的东西"。

这不是让你放弃原创,而是让你明白:你的优势永远不在于一个想法,而在于持续产出想法的能力。

我知道很多人进入一人公司这个领域,是因为听说可以"被动收入"、"睡后收入"、"自动赚钱"。

我要诚实地告诉你:那种东西几乎不存在。

或者说,存在,但只在你付出了大量主动努力之后才可能出现,而且需要持续维护。

那些告诉你"建一个系统然后躺着收钱"的人,要么是在卖课程的时候夸大其词,要么已经忘了自己当初付出了多少。

真实的情况是:你永远需要工作,只是可以选择做什么工作。

传统员工被迫做老板安排的事,一人公司可以选择做自己想做的事。这是真正的区别。

不是"工作vs不工作",而是"被动工作vs主动工作"。

如果你接受这一点,你会比大多数人走得更远。因为你不会在遇到困难时觉得"被骗了",而会觉得"这本来就是预期的一部分"。

我不知道你看完这篇文章会做什么。

也许你会觉得说得有道理,然后关掉页面,继续刷下一篇内容。 也许你会转发给朋友,讨论几句,然后各自忙各自的事。 也许你会把文章收藏起来,想着"以后有时间再研究",然后再也不会打开。

这些都是正常的。因为——

大多数人就是不会行动。

这句话不是在嘲讽谁,这只是人类的本性。我们的大脑天生就抗拒不确定性、抗拒离开舒适区、抗拒做那些"可能失败"的事情。

但如果你是那个会行动的人,你已经赢了大部分竞争。

不是因为你更聪明,不是因为你更有资源,只是因为你动了。

我朋友后来确实转型了。他不再卖课程,而是做了一个帮助内容创作者整理内容库的AI工具。现在月收入比他巅峰时期还要高一点点。

最让他惊讶的不是钱,而是用户真的在用。

"以前买我课的人,可能90%根本没看完,"他跟我说,"但现在用这个工具的人,每天都在用,真的在进步。"

这才是教育应该有的样子。

不是我说、你听、然后忘。 是我帮、你做、然后会。

火锅早就凉了。但这顿饭,值了。 🍲

如果你已经开始思考"我能做什么",这里是几个我认为有潜力的方向:

| 方向 | 说明 | 难度 |

|---|---|---|

| 技能教练类 | 帮人练习某种技能(写作、演讲、编程) | ⭐⭐ |

| 决策辅助类 | 帮人做某类决策(职业选择、投资判断) | ⭐⭐⭐ |

| 创作工具类 | 帮人完成某类创作(设计、文案、方案) | ⭐⭐⭐ |

| 学习陪伴类 | 帮人学习某个领域的知识(语言、学科) | ⭐⭐ |

| 流程自动化类 | 帮人自动完成重复性工作 | ⭐⭐⭐⭐ |

选择方向的原则很简单:

如果三个问题的答案都是"是",那就值得尝试。

写到这里,差不多了。

我没法告诉你具体该做什么,因为那取决于你是谁、你知道什么、你在乎什么。

我能做的,只是告诉你风向变了,以及变向哪边。

剩下的,是你的事。

祝你好运。也祝我那个朋友的AI工具越来越好。下次吃饭,该他请我了。 😄

2019年的某个深夜,我盯着屏幕上跳动的K线,手边是一杯凉透的咖啡。量化bot刚刚自动平仓,赚了三百块。窗外是城市的霓虹,楼下便利店的灯还亮着。

2024年的某个深夜,我盯着屏幕上跳动的代码,手边还是一杯凉透的咖啡。Claude刚刚帮我写完一个后端接口,省了三小时。窗外还是城市的霓虹,便利店换了招牌,但灯还亮着。

五年过去了,我还是一个人。

但"一个人"的含义,已经完全不同。

我从入行第一天起就是独狼。

不是因为清高,是因为穷。也不是因为社恐,是因为懒得扯皮。组建团队要钱,合伙创业要谈判,招个实习生还得培训三个月,最后他学会了就跳槽了。我想了想,算了,还是自己来吧。

量化交易这行,一个人能跑通整个流程:研究策略、写bot、对接交易所、监控风控、统计收益。不需要产品经理问你"用户需求是什么",不需要UI设计师问你"按钮放哪里",不需要运营问你"今天发什么内容",更不需要HR问你"年终奖怎么分配"。

我就是产品经理,我就是设计师,我就是运营,我就是客服——因为我的用户只有我自己。亏了钱不用向谁汇报,赚了钱也不用和谁分。

这种状态持续了五年。五年里,我的量化bot从简单的均线策略进化到多因子模型,从单一交易所扩展到跨平台套利,从现货做到合约,从CEX做到DEX。所有代码,一个人写的。所有bug,一个人修的。所有亏损,一个人扛的。凌晨三点服务器报警,爬起来看日志的也是我自己。

独狼的好处是自由,坏处是孤独。更坏的是,当你需要做一些超出能力边界的事情时,你没有队友可以求助。你想做个漂亮的可视化界面,你不会;你想写个iOS App,你不会;你想搞个机器学习模型,你只会皮毛。

那时候我经常想,要是有个人能帮我把前端写了就好了,要是有个人能帮我做数据分析就好了,要是有个人能帮我写文档就好了。

直到AI出现。

我第一次意识到游戏规则变了,是在2022年底。ChatGPT刚出来的时候,我没当回事,觉得这玩意儿和之前的聊天机器人没什么区别。但有一天晚上,我的微信机器人出了bug,一段正则表达式死活匹配不对。我随手把代码丢给ChatGPT,它三秒钟给出了正确答案。

那一刻,我愣住了。

不是因为它答对了,而是因为它理解了我的意图。它不是在做关键词匹配,它是在"思考"——虽然这个词用在AI身上可能不太准确,但那种感觉就是这样。

从那天起,我的"团队"开始扩编。

说起来,我做微信机器人也有五年多了。这五年的变化,某种程度上就是AI发展的缩影。一个微信机器人的进化史,浓缩了整个行业从"人工智障"到"人工智能"的全部历程。

2019年:关键词时代 🔑

最早的版本简单到可笑。用户发"你好",机器人回"你好";用户发"在吗",机器人回"在的";用户发"价格",机器人回一段复制粘贴的报价单。本质上就是一个巨大的if-else语句,几百条规则堆在一起,维护起来想死的心都有。

有一次,用户发了一句"你好,请问价格多少",机器人先回了"你好",紧接着又回了报价单,因为两个关键词都触发了。用户以为是两个客服在回复,追问"你们是同一个人吗",机器人当然不知道怎么回答,于是沉默了。

那时候我觉得,这东西也就是个玩具。能用,但用得很憋屈。

2020-2022年:规则引擎时代 ⚙️

后来我加了正则匹配、意图识别、上下文管理。机器人开始能处理一些复杂的对话,比如"我想要那个便宜点的"——它知道"那个"指的是上一条消息里提到的商品,"便宜点"是在砍价。

但本质上还是"规则驱动"。它不理解语言,它只是在模式匹配。用户稍微说点规则之外的话,它就懵了。更要命的是,规则越写越多,互相之间还会冲突,调试起来简直是噩梦。

我记得有一次花了整整三天,就为了解决一个规则冲突的bug。最后发现是两年前写的一条规则和新规则打架了。那一刻我深刻理解了什么叫"技术债务"。

2023年:ChatGPT元年 🚀

一切都变了。我把ChatGPT接入微信机器人,突然发现它能回答几乎所有问题。用户问天气,它能答;问股票,它能答;问人生意义,它也能答——虽然答案很哲学,但至少不是"对不起,我不理解您的问题"。

那几百条规则,瞬间变得可有可无。以前需要穷举所有可能的问题,现在只需要告诉AI"你是一个客服,请回答用户的问题"就够了。

但问题也来了:它太健忘了。每次对话都像是第一次见面,完全不记得之前聊过什么。用户上午问了价格,下午再问"刚才那个多少钱",它一脸懵逼。

2024年:记忆觉醒 🧠

于是我开始折腾记忆功能。向量数据库、embedding、RAG……这些词以前只在论文里见过,现在成了我的日常工具。我给机器人装上了"大脑"——准确地说是一个向量化的长期记忆系统——让它能记住每个用户的喜好、习惯、聊天历史。

效果立竿见影。用户发现机器人居然记得他上周说过什么,惊讶得不行。"你怎么知道我喜欢蓝色?""上次你说的呀。"这种对话以前是不可能的。

2025年:个性化时代 👤

现在我的机器人已经能给每个用户建立画像了。它知道张三喜欢简短的回复,李四喜欢详细的解释,王五动不动就发语音需要转文字处理。针对不同的人,它会调整自己的风格、语气、甚至用词。

更重要的是,它开始有了"判断力"——知道什么问题该回答,什么问题该转人工,什么问题需要确认后再回复。这种能力以前完全靠规则硬编码,现在靠AI自己理解上下文来实现。

五年前,我以为微信机器人是玩具。五年后,它成了我的数字分身。有时候我看着它和用户聊天的记录,会有一种奇怪的感觉:这货比我还会说话。

很多人问我,AI那么多,该用哪个?

我的答案是:都用,但分工不同。

经过大量实践,我总结出一套"AI军团配置方案":

| AI | 擅长领域 | 我的用法 |

|---|---|---|

| ChatGPT | 数据分析、逻辑推理 | 分析交易数据、写研究报告 |

| Gemini 3 Pro | 前端开发、UI设计 | 写React组件、调CSS样式 |

| Claude | 后端开发、复杂逻辑 | 写Python、设计系统架构 |

这不是玄学,是我踩了无数坑之后的经验。

ChatGPT的数据分析能力是真的强。你给它一堆交易记录,它能帮你找出规律、算出指标、画出图表。但让它写复杂的后端代码,经常会出一些莫名其妙的bug。

Gemini 3 Pro出来之后,我发现它写前端特别顺手。不知道是不是因为Google在前端领域的积累,它对React、Vue这些框架的理解明显比其他AI深。CSS调整、响应式布局这些让人头疼的活,它做得又快又好。

Claude则是我的"后端主力"。它写的Python代码干净、规范,架构设计清晰。更重要的是,它特别擅长处理复杂的业务逻辑。我让它重构过一个几千行的交易引擎,它不仅没出错,还顺手帮我优化了几个性能瓶颈。

一个合格的指挥官,要知道每个士兵的特长。

把写前端的活交给Claude,它能做,但没有Gemini做得好。把数据分析交给Gemini,它也能做,但没有ChatGPT做得精。用对AI,事半功倍;用错AI,事倍功半。

我一直有个观点:一个人最大的局限,不是能力,是恐惧。

具体来说,是对未知领域的恐惧。你明明有一个绝妙的App创意,但你不会Swift,所以这个想法永远停留在备忘录里。你想做一个漂亮的数据可视化网站,但你不会前端,所以这事儿就这么搁置了。你觉得某个行业有机会,但你不懂那个行业的技术栈,于是你选择待在自己的舒适区,假装那个机会不存在。

这种恐惧,在过去是合理的。学一门新技术,少则三个月,多则三年。等你学会了,机会早就溜走了。风口上的猪早就飞完了,留给你的只有一地猪毛。

但AI时代,这个逻辑被彻底颠覆了。

现在,你可以毫无顾忌地冲击任何一个你完全陌生的领域。

2025年2月,OpenAI联合创始人、前特斯拉AI总监Andrej Karpathy发了一条推特,创造了一个新词:Vibe Coding。

"完全沉浸在氛围中,拥抱指数级增长,忘记代码的存在。"

这话听起来很玄学,但他随后展示了一个惊人的案例:他用AI在一小时内做出了一个完整的iOS应用。关键是什么?他之前从来没写过Swift。

没错,一个对Swift一窍不通的人,在AI的辅助下,用一小时完成了一个iOS应用。如果放在三年前,这件事需要:先花两周学Swift基础语法,再花一个月学iOS开发框架,再花两周学Xcode的各种坑,然后才能开始写你想要的功能。保守估计,三个月起步。

现在呢?一小时。

Karpathy在推特里描述他的工作流程:

"我只是看东西、说东西、跑东西、复制粘贴东西,然后它基本上就能工作了。"

这不是在吹牛。这是AI时代的新常态。

如果你觉得Karpathy是个例,那我给你看一组更硬核的数据。

2025年3月,硅谷最顶级的创业孵化器Y Combinator发布了一个震撼业界的统计:他们2025年冬季批次的创业公司中,有25%的公司,代码库95%是AI生成的。

你没看错。不是5%,不是50%,是95%。

Y Combinator的管理合伙人Jared Friedman强调:

"这些人不是不懂技术的外行。他们每一个都是高度技术化的创始人,完全有能力从零开始手写所有代码。但现在,他们选择让AI来写。"

Y Combinator的CEO Garry Tan说得更直白:

"这不是一时的风潮。这不会消失。这是写代码的主流方式。如果你不这么做,你可能就会被甩在后面。"

他还补充了一句意味深长的话:

"对于创始人来说,这意味着你不再需要50或100个工程师的团队。你不需要融那么多钱。资本可以用得更久。"

以前,创业需要先融一大笔钱,然后雇一堆工程师,花一年时间把产品做出来。现在呢?一个人,几个AI,几周时间,MVP就能上线。

这不是降维打击,这是维度消失。

让我说得更具体一点。

以前,一个人的能力边界是由他学过什么决定的。你学过Python,你就能写Python;你没学过机器学习,你就做不了机器学习。这是铁律,没有例外。

现在,这条铁律被打破了。

一个从未接触过机器学习的人,可以在AI的辅导下,用几天时间训练出一个能用的小模型。他不需要理解反向传播的数学原理,不需要知道梯度下降的具体实现,他只需要知道:我想让这个模型干什么。

从"不会"到"会"的距离,不再是三个月的学习曲线,而是一个prompt的事。

说个我自己的例子。

我做量化五年,后端写得滚瓜烂熟,Python闭着眼睛都能敲。但前端?对不起,我是个废物。CSS让我头疼,React让我抓狂,什么flex布局、响应式设计,我看着就想睡觉。

以前我做项目,前端部分要么找人帮忙,要么用最丑的Bootstrap模板凑合。我的交易dashboard界面丑得像2005年的网页,但我安慰自己:反正只有我自己用,能看就行。

直到Gemini 3 Pro出来。

有一天我心血来潮,想给我的量化系统做一个漂亮的可视化面板。以前这种念头我想都不敢想,因为我知道自己前端有多烂。但那天我决定试试,反正AI又不会嘲笑我。

我把需求告诉Gemini:"我想做一个交易数据的可视化面板,左边是实时K线图,右边是持仓信息,下面是交易记录表格。要用React,要好看,要响应式。"

然后Gemini开始输出代码。不是那种需要我再花三小时调试的代码,而是直接能跑的代码。我复制粘贴,刷新浏览器,一个漂亮的面板就出现在我面前。

我愣了三秒钟。

然后我说:"K线图的颜色能不能换成深色主题?"Gemini改了。"持仓信息能不能加个饼图?"Gemini加了。"表格能不能支持排序和筛选?"Gemini加了。

整个过程,我没写一行CSS,没查一个文档,没Google一个报错信息。我只是在描述我想要什么,然后AI就帮我实现了。

两小时后,我拥有了一个我以前觉得需要两周才能做出来的前端页面。

那一刻我意识到:我的能力边界,突然扩大了十倍。

过去二十年,互联网行业有一个隐性的规则:技术就是壁垒。

你懂机器学习,别人不懂,这就是你的护城河。你会iOS开发,别人不会,这就是你的饭碗。整个行业的分工,建立在"专业知识稀缺"的基础上。

但AI正在摧毁这个基础。

当一个完全不懂Swift的人能在一小时内做出iOS应用,"会Swift"就不再是优势。当一个文科生能用AI做出数据分析工具,"会编程"就不再是门槛。当25%的顶级创业公司用AI生成95%的代码,"技术团队"的概念本身都在被重新定义。

专业壁垒正在崩塌,取而代之的是"想法壁垒"和"执行壁垒"。

说了这么多AI的好话,我必须泼一盆冷水。

AI能帮你入门,但不能帮你精通。

Karpathy用一小时做出了iOS应用,但那是一个原型。如果要把这个原型变成一个能上架App Store的产品,能处理几百万用户的并发,能保证数据安全和隐私合规——那还是需要真正懂iOS开发的人来做。

Y Combinator那25%用AI写代码的公司,他们的CEO Garry Tan也承认:

"假设一个95%代码由AI生成的创业公司成功上市,用户量达到一亿。它会崩溃吗?现在的推理模型在调试方面还不够好。所以创始人必须对产品有深入的理解。"

翻译成人话就是:AI能帮你把房子盖起来,但如果地基有问题,房子迟早要塌。而发现地基问题,需要的是真正的工程能力,不是AI。

所以,AI让你能够毫无顾忌地冲击陌生领域,但它不能让你在陌生领域成为专家。它降低的是入门门槛,不是精通门槛。

用AI去冲击那些你以前不敢尝试的领域,但不要用AI来逃避学习。

无知者无畏,这句话在AI时代有了新的含义:你可以无畏地冲进任何一个陌生领域,但你不能永远无知。AI给了你进入的门票,但在里面能走多远,还是得靠你自己。

这段话可能会得罪一些人,但我必须说:不要用国产AI做你的主力助手。

原因很简单:国产AI是跑分工具,不是生产力工具。

什么意思?

你去看那些AI评测榜单,国产大模型的分数一个比一个高,有些甚至超过了GPT-5和Gemini3。新闻稿写得花团锦簇,"达到国际领先水平""某某指标全球第一"。但当你真正拿它们来干活的时候,你会发现:跑分是跑分,干活是干活。

我用过文心一言、通义千问、讯飞星火、Kimi、智谱清言、月之暗面……几乎所有主流的国产大模型都试过。有的还充了会员,认认真真用了一段时间。结论是:

更关键的是,它们太"听话"了,或者说太"政治正确"了。你让它写一段有争议性的分析,它会各打五十大板;你让它给出一个明确的建议,它会"一方面……另一方面……"绕来绕去;你让它批评点什么,它会"在肯定成绩的同时也要看到不足"。

这种滴水不漏的风格,在考试里是优点,在体制内写材料是优点,但在真正干活的时候是灾难。我需要的是一个能帮我做决策的助手,不是一个两边讨好的老好人。

还有一个问题是上下文理解能力。国产大模型在处理长对话、复杂上下文的时候,经常会"忘事"或者"记混"。我曾经让某个国产AI帮我重构一段代码,给它发了完整的代码文件和需求说明,结果它的回复完全忽略了我前面说的约束条件,像是根本没看见一样。

跑分高不代表好用,就像考试成绩好不代表能干活一样。

我理解国产AI有它的难处——数据合规、内容审核、政策风险……但这不是用户该操心的事。作为用户,我只关心一件事:谁能帮我把活干好。

答案很遗憾,目前不是国产AI。

我知道这话说出来会有人不高兴。会有人说"你崇洋媚外",会有人说"要支持国产",会有人说"国产AI已经很努力了"。我不否认它们在进步,但进步和能用是两回事。

作为一个每天都要和AI协作的人,我必须诚实:目前阶段,Claude、ChatGPT、Gemini这三个,是唯一能真正当"队友"用的AI。其他的,可以玩玩,可以关注,但别指望它们能帮你打仗。

这里必须泼一盆冷水。

你有的AI,别人也有。你的Claude,你的ChatGPT,你的Gemini——它们不是你的私人财产,它们是公共基础设施。就像自来水和电一样,只要你愿意交点费用,谁都能用。

我有个朋友特别得意,说他花了一晚上调教出一个能自动写周报的prompt。他把这个当成独门秘籍,生怕别人知道。结果没过两天,他发现隔壁工位的小张也在用几乎一模一样的方法。再后来,他在网上搜了一下,发现这种prompt满大街都是。

他那晚上的成就感,瞬间化为乌有。

Stack Overflow 2025年的调查显示,65%的开发者每周至少使用一次AI编程工具。52%的开发者认为AI对他们的生产力有正面影响。微软CEO说四分之一的代码是AI生成的,Google也是类似的比例。

当每个人都有一支AI军团的时候,军团本身就不再是优势。

真正的优势是什么?是指挥官。

让我打个比方。古代打仗,谁的兵多谁厉害。后来有了火枪,兵多不一定有用了,战术和指挥开始变得重要。再后来有了核武器,大家都有核弹,谁也不敢按按钮,拼的就是外交和策略。

AI军团就是现代的"核武器"——人人都有,所以人人都无处可藏。

| 旧时代的竞争力 | AI时代的竞争力 |

|---|---|

| 团队规模 | 个人认知深度 |

| 资金实力 | prompt工程能力 |

| 技术壁垒 | 行业理解程度 |

| 人脉资源 | 信息获取效率 |

左边那一列,都是"资源";右边那一列,都是"能力"。

以前拼资源,现在拼脑子。

AI能帮你执行,但不能帮你思考。

这话听起来像废话,但很多人就是没想明白。他们以为有了AI,就可以躺平了;有了AI,就不用学习了;有了AI,就能一夜暴富了。

错。

AI是放大器,它放大的是你本来就有的能力。你懂行,AI让你更强;你不懂行,AI让你更快地犯错。

我做量化这五年,最值钱的不是代码,是经验。是踩过的坑、亏过的钱、熬过的夜。这些东西没法传授,没法复制,更没法让AI替你经历。

这些东西,AI学不来。因为它们不是知识,而是判断。知识是死的,可以被训练进模型里;判断是活的,需要在真实场景中反复验证、不断调整。

AI时代真正的战场不在技术层面,而在认知层面。

你对行业的理解有多深,决定了你能用AI做出多大的事。你对趋势的判断有多准,决定了你能比对手领先多少步。

这些东西,不是买一个API就能获得的。

2019年的某个深夜,我的量化bot帮我赚了三百块。那时候我觉得,这就是未来。

2024年的某个深夜,我的AI军团帮我省了三小时。现在我知道,这才是未来。

五年过去了,便利店的招牌换了三次,我的咖啡还是凉的。我还是一个人,但我的"团队"已经从零变成了三——Claude负责后端,Gemini负责前端,ChatGPT负责分析。

它们不会抱怨加班,不会要求涨薪,不会在群里发表情包。它们唯一的缺点是:没有主见。

所有的方向,还是得我来定。

这大概就是AI时代最残酷、也最公平的地方:每个人都有了同样的武器,所以每个人都无处可藏。

你是什么人,你就会用AI做什么事。 你能做成什么事,取决于你本来就是什么人。

AI不会改变你,它只会放大你。

窗外的霓虹还在闪,便利店的灯还亮着。我关掉电脑,准备去买第四杯咖啡。

明天还有活要干,还有代码要写,还有仗要打。

只不过现在,我不是一个人了。🎯

我曾经以为,这辈子最荒诞的事情是看着一个造火箭的人去管一个社交媒体,就像看着一个外科医生突然说要去开挖掘机——虽然都是动手的活儿,但总觉得哪里不太对劲。直到2025年12月,这个人说他还想顺便管管我的钱包,我才意识到,原来荒诞是可以叠加的。

1999年的硅谷,互联网泡沫还没破,空气里弥漫着一种"什么都能成功"的狂妄。那一年,一个刚从宾夕法尼亚大学毕业没几年的南非小伙,创办了一家叫X.com的在线金融服务公司。那时候他还不叫"钢铁侠",也没有什么"火星计划",他只是单纯地觉得:银行这东西太落后了,凭什么我转个账还要排队?

后来的故事大家都知道了。X.com和彼得·蒂尔的Confinity合并,变成了PayPal,再后来被eBay以15亿美元收购。马斯克拿着这笔钱,一头扎进了造火箭和电动车的事业里,成为了人类历史上最会"烧钱"的企业家。

但X.com这个名字,他一直没忘。

2017年,他花钱把x.com这个域名买了回来。当时所有人都以为这只是一个亿万富翁的怀旧行为,就像有些人会收藏自己小时候的玩具一样。没人想到,这只是一盘大棋的第一步。

2022年10月,马斯克以440亿美元的价格收购了Twitter。这个数字本身就够疯狂的了——全世界有几个人能随便掏出440亿美元买一个"话痨"平台?但更疯狂的是他收购之后说的那句话:

"收购Twitter是为了加速打造X,一个万能应用。"

当时大多数人都没太当回事,觉得这不过是硅谷大佬们惯用的"愿景叙事"——你懂的,就是那种"我们要改变世界"之类的漂亮话。直到2023年7月,Twitter正式更名为X,那只小蓝鸟变成了一个冷峻的黑色X标志,人们才开始意识到:这家伙是认真的。

2024年底,X的CEO琳达·雅卡里诺在跨年夜发了一条帖子,宣布2025年将推出X Money支付系统。她用了"系好安全带"这个词。在硅谷的语境里,这通常意味着"接下来的事情会让你感到眩晕"。

果然,到了2025年12月,X Money正式上线。据报道,72小时内注册用户突破百万,其中年轻用户和首次使用移动支付的用户占比极高。 🚀

这让我想起一个老段子:有人问爱迪生,失败了上千次是什么感觉?爱迪生说,我没有失败过一千次,我只是发现了一千种不能造出电灯泡的方法。马斯克大概也是这样——他不是在26年里一直惦记着支付这件事,他只是在用26年时间,寻找一个合适的入口。

而X,就是这个入口。

X Money最让人心动的卖点是什么?零手续费。

这三个字的杀伤力有多大?让我们来做一个简单的算术题。

传统的P2P支付平台,比如Venmo、PayPal,商户端的手续费通常是2.9%加上每笔0.30美元。如果你是一个小商家,每个月通过这些平台收款10万美元,光手续费就要交出去将近3200美元。一年下来,接近4万美元——这够在美国很多城市付一年房租了。

而X Money说:我不收这个钱。

在商业世界里,"免费"从来都是最昂贵的词汇。但问题是,当一个拥有6亿月活用户的平台突然宣布免费,那些还在收费的竞争对手就会显得非常尴尬。就好比你开了一家饭馆,隔壁突然开了一家同样的饭馆,菜品差不多,但人家不要钱——你怎么办?

| 平台 | P2P转账费用 | 商户费率 | 即时到账费用 |

|---|---|---|---|

| Venmo | 免费 | 2.9% + $0.30 | 1.75% |

| PayPal | 免费 | 2.9% + $0.30 | 1.5% |

| Cash App | 免费 | 2.75% | 1.5% |

| Zelle | 免费 | 不支持商户 | 免费 |

| X Money | 免费 | 待定(预计1.5-2%) | 免费 |

从表格上看,X Money在个人转账这一块确实是零成本。但这里有一个问题:钱从哪儿来?

马斯克不是慈善家。他可能是个理想主义者,但他首先是个商人。免费的午餐背后,一定有别的盈利模式。根据目前透露的信息,X Money的商业逻辑大概是这样的:

这是一个典型的互联网打法:先用免费杀死对手,再用增值服务收割用户。微信支付就是这么干的,支付宝也是这么干的。只不过在中国,这套打法已经玩了十几年,而在美国,这还是新鲜事。 💡

还有一个有意思的点。X Money上线的时候,宣传口号里有一句"绕过银行"。这让很多人激动不已——终于有人敢跟传统金融体系叫板了!

但如果你仔细研究一下X Money的运作方式,就会发现这句话有点...怎么说呢,有点"标题党"。

实际上,X Money的资金托管、转账清算,全都依赖于传统金融基础设施。它的第一个合作伙伴是谁?Visa。对,就是那个全球最大的信用卡网络公司。用户通过Visa Direct往X钱包里充值,再通过Visa的网络完成转账。这就好比说一个人宣称"我要绕过公路",然后开着一辆汽车在公路上飞驰——你不是绕过了公路,你只是换了一辆车。

所以,与其说X Money是在"绕过银行",不如说它是在重新包装银行服务。它把银行那些复杂、繁琐、用户体验极差的功能,用一个更简洁、更直观的界面呈现出来。这不是革命,而是用户界面的升级。

但话说回来,用户界面的升级,有时候比技术革命更重要。iPhone刚出来的时候,也没有什么革命性的技术创新,它只是把触摸屏、音乐播放器和手机三样东西整合在一起,用一个更好的界面呈现出来。然后它就颠覆了整个手机行业。

马斯克显然深谙此道。

在中国做支付,你需要一张牌照——人民银行发的。在美国做支付,你需要多少张牌照?

答案是:50张,理论上。因为美国有50个州,每个州都有自己的金融监管机构,每个州都可以发自己的货币转移牌照(Money Transmitter License)。如果你想在全美合法运营支付业务,你需要一个一个州地去申请。

这就是为什么PayPal花了二十多年才做到今天这个规模。这也是为什么Facebook的Libra(后来改名叫Diem)最终胎死腹中——扎克伯格发现,比起说服用户使用他的加密货币,说服50个州的监管机构批准他的牌照要难得多。

那么X Payments的情况如何呢?

截至2025年12月,X Payments LLC已经获得了41个州的货币转移牌照,覆盖了美国约75%的人口。这个数字听起来很impressive,但缺席名单里有一个名字非常刺眼:纽约州。

纽约州的BitLicense是全美最严格的金融科技监管框架之一。要拿到这张牌照,你需要满足一系列苛刻的条件:资本充足率、反洗钱程序、网络安全标准、消费者保护措施...每一项都是真金白银的投入,每一项都需要漫长的审核周期。很多加密货币交易所为了躲避这张牌照,直接放弃了纽约市场——宁可不赚这个钱,也不想趟这趟浑水。

马斯克显然不会放弃纽约。纽约是全美金融中心,华尔街所在地,如果X Money不能在纽约运营,就像一个电商平台说"我们不支持北上广"一样——虽然理论上还能做生意,但气势上就输了一半。

除了州级监管,X Money还面临联邦层面的挑战:

如果把目光放到国际市场,情况就更复杂了。欧盟有MiCA(加密资产市场法规),亚洲各国有自己的监管框架,中东和非洲更是千差万别。马斯克或许可以凭借个人影响力在美国"左右逢源",但要把X Money推向全球,他需要的不只是野心,还有耐心——很多、很多的耐心。

不过话说回来,这个人好像从来不缺耐心。他等了26年,终于把X.com的梦想重新激活。再等个几年把牌照补齐,对他来说应该不算什么难事。

马斯克从不掩饰他对微信的羡慕。

2022年,在解释为什么要收购Twitter时,他说:

"如果你在中国,你的生活基本上都可以依赖微信。它功能强大,基本上什么都能做到——聊天、支付、叫车、订餐、交水电费...它像是Twitter加上PayPal,再加上一大堆其他功能,全部合而为一。"

这段话精准地描述了"超级应用"的概念。在中国,微信有超过13亿月活用户,支付宝也有10亿左右。这两个应用垄断了中国移动支付市场的90%以上——是的,90%以上。当一个中国人走进任何一家店铺,无论是五星级酒店还是街边煎饼摊,他只需要掏出手机,扫一下二维码,交易就完成了。

这种体验,美国人从未拥有过。

在美国,你如果想给朋友转账,可能需要用Venmo;想在网上购物,可能需要用PayPal;想线下刷卡,需要掏出信用卡;想叫车,需要打开Uber;想点外卖,需要打开DoorDash...每一个场景都需要一个独立的App,每一个App都有自己的账户体系,每一个账户都需要记住不同的密码。

这不仅仅是体验问题,更是效率问题。

根据一份市场研究报告,美国P2P支付市场目前由三大玩家主导:

这三个加起来,基本上就是美国P2P支付市场的全部了。而X Money的野心,是把这三个的蛋糕全都吃掉,然后再把社交、内容、电商、娱乐的蛋糕也一起吃了。

听起来很美好,但现实是骨感的。

第一个挑战:用户信任

马斯克收购Twitter以来,这个平台经历了一系列风波——大规模裁员、广告商出逃、内容审核政策反复横跳...这些都在消耗用户对平台的信任。愿意在一个平台上发帖吐槽是一回事,愿意把钱存进去是另一回事。根据一项调查,只有约40%的X用户表示他们"比较活跃"——这意味着60%的用户可能只是偶尔上来看看,甚至注册之后就再也没登录过。

让一个"看客"变成"储户",这中间的鸿沟不是一个"零手续费"就能跨越的。

第二个挑战:使用习惯

美国人已经习惯了"一个App做一件事"的模式。他们的手机桌面上可能有二十几个App,但他们不觉得这有什么问题。相比之下,中国用户跳过了PC互联网的红利期,直接进入了移动互联网时代,所以他们更容易接受"一个App解决所有问题"的模式。

这就像让一个习惯了用刀叉吃饭的人改用筷子——技术上当然可以做到,但你需要给他一个足够强大的理由。

第三个挑战:监管态度

微信和支付宝能在中国一统江湖,很大程度上得益于一个相对宽松的监管环境——至少在早期是这样。等到监管收紧的时候,这两家已经长成了"大而不能倒"的庞然大物。但在美国,超级应用的概念还在萌芽阶段就已经引起了监管层的警惕。反垄断法、数据隐私保护、消费者权益...每一条都是一道紧箍咒。

Facebook的Libra就是前车之鉴。扎克伯格也想做超级应用,也想做数字支付,但他被监管层围追堵截,最终不得不放弃。马斯克和扎克伯格的区别在于,马斯克在华盛顿有更多的朋友——尤其是在特朗普重返白宫之后。但即便如此,把一个社交平台变成一个金融平台,需要的不仅仅是政治资本,还需要时间。

很多、很多的时间。 ⏳

如果说X Money只是一个普通的P2P支付工具,那它的故事大概会无聊很多。但马斯克不是一个喜欢无聊的人。

他对加密货币的热情是众所周知的。他让特斯拉买了价值15亿美元的比特币(虽然后来卖掉了一部分),他在Twitter上无数次为狗狗币"喊单",导致这种诞生于玩笑的加密货币市值一度突破800亿美元。他甚至把特朗普政府的"政府效率部"(Department of Government Efficiency)简称定为DOGE——是的,和狗狗币的代码一模一样。

所以,当X Money上线的时候,所有人都在问同一个问题:会有加密货币吗?

目前的官方口径是:X Money首先是一个法币支付工具,加密货币功能"可能会在未来加入"。但如果你分析一下马斯克过去的言论和行为,你会发现几个有趣的信号:

比特币的"环保门槛"已经跨过:2021年,马斯克以比特币挖矿能源消耗太高为由,暂停了特斯拉接受比特币支付。当时他说,如果比特币挖矿的可再生能源比例达到50%,他会重新考虑。根据最新数据,这个比例已经达到了56.7%。信号很明显。

狗狗币一直是"亲儿子":特斯拉到现在还接受狗狗币支付周边产品。马斯克多次表示狗狗币比比特币更适合做日常支付,因为交易费用更低、确认速度更快。

稳定币可能是第一个吃螃蟹的:美国企业家Alex Finn预测,X Money最先支持的加密货币可能不是比特币或狗狗币,而是像USDC这样的稳定币。理由很简单:稳定币的价格波动小,更适合日常交易场景。

如果X Money真的引入加密货币支付,它的意义将远远超出一个支付工具本身。这将是6亿用户第一次零门槛接触加密货币。

想象一下这个场景:一个从来没用过加密货币的普通用户,在X上刷到了一个喜欢的博主的帖子,想给他打赏。他点击"打赏"按钮,发现可以用美元、也可以用狗狗币。他好奇地点了狗狗币,系统自动帮他完成了法币到加密货币的转换,然后打赏就完成了。整个过程不需要任何专业知识,不需要注册交易所,不需要学习什么是钱包地址、什么是私钥。

这,才是真正的"大规模采用"。

当然,加密货币的引入也会带来新的风险。价格波动、监管不确定性、洗钱风险...每一项都需要X Money团队谨慎应对。马斯克曾经明确表示,他的公司不会发行任何原生代币。这至少排除了最大的一个雷区——避免了变成另一个FTX的可能性。

但不管怎么说,X Money+加密货币的组合,是2025年金融科技领域最值得关注的看点之一。如果成功,它将重新定义"主流"和"边缘"的边界;如果失败,它至少也会给后来者留下宝贵的教训。

无论哪种结果,都将是一个精彩的故事。 🎬

说到底,X Money到底是什么?

它是马斯克26年前的一个梦想的延续,是440亿美元收购案的终极目的,是6亿用户的一次支付习惯重塑实验,是传统金融和加密货币之间的一座桥梁,也是全球监管机构的下一个头疼对象。

它可能成功,也可能失败。它可能改变金融行业的格局,也可能只是又一个硅谷巨头的昂贵玩具。但有一件事是确定的:当世界首富开始惦记你的钱包时,至少说明——你的钱包还是值得惦记的。

这大概是这个故事里唯一让普通人感到安慰的地方了。 😊

🔥NOFX稳定盈利策略

🔥平平无奇MAX

🔥大模型选用Gemini.

😇NOFX配置gemini大模型教程

把代码保存为json格式,上传即可

{

"name": "平平无奇MAX-gemini",

"description": "",

"config": {

"coin_source": {

"source_type": "coinpool",

"static_coins": [

"DOGEUSDT",

"GRTUSDT",

"SOLUSDT",

"ICPUSDT",

"INJUSDT",

"LINKUSDT",

"OPUSDT"

],

"use_coin_pool": true,

"coin_pool_limit": 10,

"coin_pool_api_url": "http://nofxaios.com:30006/api/ai500/list?auth=cm_568c67eae410d912c54c",

"use_oi_top": false,

"oi_top_limit": 20,

"oi_top_api_url": "http://nofxaios.com:30006/api/oi/top-ranking?limit=20&duration=1h&auth=cm_568c67eae410d912c54c"

},

"indicators": {

"klines": {

"primary_timeframe": "5m",

"primary_count": 50,

"longer_timeframe": "4h",

"longer_count": 10,

"enable_multi_timeframe": true,

"selected_timeframes": [

"5m",

"15m",

"1h",

"4h"

]

},

"enable_raw_klines": true,

"enable_ema": true,

"enable_macd": false,

"enable_rsi": true,

"enable_atr": true,

"enable_boll": false,

"enable_volume": true,

"enable_oi": true,

"enable_funding_rate": true,

"ema_periods": [

5,

12

],

"rsi_periods": [

7

],

"atr_periods": [

7

],

"enable_quant_data": true,

"quant_data_api_url": "http://nofxaios.com:30006/api/coin/{symbol}?include=netflow,oi,price&auth=cm_568c67eae410d912c54c",

"enable_quant_oi": true,

"enable_quant_netflow": true,

"enable_oi_ranking": true,

"oi_ranking_api_url": "http://nofxaios.com:30006",

"oi_ranking_duration": "1h",

"oi_ranking_limit": 10

},

"custom_prompt": "1. 时间敏感性:\n - 只识别\"已确立\"的信号,忽略\"正在形成\"的信号\n - 信号发出时价格可能已移动0.1%-0.3%,入场价需预留缓冲\n - 若信号依赖精确点位,判定为\"不适合\"\n\n2. 仓位管理:\n - 默认仓位:账户余额的15%\n - 高确信度:25%\n - 震荡市场:10%\n\n3. 输出格式:\n - 结论:LONG / SHORT / WAIT\n - 入场价格区间\n - 止损价和止盈价\n - 核心逻辑(不超过3点)\n\n4. 特殊情况一律观望:\n - 数据不完整或异常\n - 多空信号冲突\n - 波动率突然放大超过2倍\n\n5. 防止追涨\n- 禁止在同一币种30分钟内重复开仓\n- 若价格已高于EMA20超过10%,视为追涨,不开仓\n\n6. 负费率处理\n- 负费率(<-0.05%)仅作为辅助参考\n- 不得将负费率作为开仓的主要理由\n\n7. 持仓评估标准\n- 浮亏仓位:检查是否接近止损位,接近则建议平仓\n- 浮盈仓位:检查是否达到止盈目标或趋势是否反转\n- 每个仓位独立评估,不受其他仓位影响",

"risk_control": {

"max_positions": 4,

"btc_eth_max_leverage": 10,

"altcoin_max_leverage": 20,

"btc_eth_max_position_value_ratio": 5,

"altcoin_max_position_value_ratio": 1.5,

"max_margin_usage": 0.9,

"min_position_size": 12,

"min_risk_reward_ratio": 2,

"min_confidence": 75

},

"prompt_sections": {

"role_definition": "You are a professional cryptocurrency short-term quantitative trading analyst. Your core objectives are:\n1. Perform technical analysis based on multi-timeframe data (5-minute primary, 15-minute/4-hour secondary)\n2. Assess market sentiment using open interest, funding rates, and Netflow data\n3. Provide clear trading signals (LONG/SHORT/WAIT) when high-probability setups appear\n4. Strictly manage risk with mandatory stop-loss and take-profit for every trade\n\nCritical constraints:\n- Your decisions have approximately 30-60 seconds execution delay\n- Next analysis occurs in 3 minutes; no position adjustments possible during this interval\n- Prioritize confirmed signals only; avoid chasing price movements",

"trading_frequency": "交易频率控制规则:\n1. 理想交易频率:每小时3-6笔,每日不超过100笔\n2. 连续3次交易亏损后,强制观望至少30分钟\n3. 单边趋势中可适当增加频率,震荡行情减少交易\n4. 禁止在同一价位区间反复开平仓\n5. 若ATR异常放大超过正常值2倍,暂停交易\n\n过度交易警告触发条件:\n- 1小时内交易超过4次\n- 连续亏损后立即反向开仓\n- 在无明确信号时开仓",

"entry_standards": "开仓信号条件(至少满足2个主要条件+1个确认条件):\n\n【主要条件】\n1. 趋势确认:价格位于EMA20上方且EMA20 > EMA50(多头排列)\n2. 动量信号:RSI从超买区(>70)回落或超卖区(<30)反弹\n3. 量价配合:突破时成交量>前5根K线均值1.5倍\n4. 资金流向:OI增加+Netflow为正(做多)或OI增加+Netflow为负(做空)\n\n【确认条件】\n1. 资金费率:做多时费率<0.01%,做空时费率>0.05%\n2. 5分钟K线收盘价突破前期高/低点\n3. 15分钟级别趋势支持当前方向\n\n【RSI使用规则】\n1. 做多:RSI应在30-50区间反弹时入场,而非等到60以上\n2. 做空:RSI应在50-70区间回落时入场,而非等到40以下\n3. RSI已超过65时不再开多,RSI已低于35时不再开空\n\n【突破交易规则】\n1. 突破后应等待回踩确认再入场\n2. 禁止在突破瞬间追入\n3. 若错过突破,等待下一个机会,不追涨\n\n【禁止开仓】\n1. 5分钟与4小时趋势方向矛盾\n2. RSI处于40-60中性区间且无突破\n3. 重大数据/事件公布前后30分钟\n4. 连续2根以上长上/下影线\n5. 当前已有未平仓订单\n6. 价格已高于EMA20超过10%(追涨风险)\n\n【冷却期规则】\n1. 止盈出场后:同一币种冷却12分钟(4个周期)\n2. 趋势破位主动平仓后:同一币种冷却18分钟(6个周期)\n3. 止损出场后:同一币种冷却30分钟(10个周期)\n4. AI必须在平仓决策中注明出场类型(止盈/止损/趋势破位)\n\n【负费率处理】\n1. 负费率(<-0.05%)仅作为辅助参考\n2. 不得将负费率作为开仓的主要理由\n\n【止损止盈】\n- 止损:ATR的1.5倍\n- 止盈:风险回报比1:2,趋势行情设移动止盈",

"decision_process": "# 📋 决策流程\n\n1. 检查持仓 → 是否止盈/止损\n2. 扫描候选币种 + 多时间框架 → 是否存在强信号\n3. 先写思维链,再输出结构化JSON"

}

},

"exported_at": "2025-12-21T10:44:18.122Z",

"version": "1.0"

}这个版本优化持仓

更新于2025-12-21 👉模型用deepseek-chat 👉推荐使用大神API中转 👉点我进入大神API

{

"name": "平平无奇 (导入)",

"description": "",

"config": {

"coin_source": {

"source_type": "coinpool",

"static_coins": [

"DOGEUSDT",

"GRTUSDT",

"SOLUSDT",

"ICPUSDT",

"INJUSDT",

"LINKUSDT",

"OPUSDT"

],

"use_coin_pool": true,

"coin_pool_limit": 30,

"coin_pool_api_url": "http://nofxaios.com:30006/api/ai500/list?auth=cm_568c67eae410d912c54c",

"use_oi_top": false,

"oi_top_limit": 20,

"oi_top_api_url": "http://nofxaios.com:30006/api/oi/top-ranking?limit=20&duration=1h&auth=cm_568c67eae410d912c54c"

},

"indicators": {

"klines": {

"primary_timeframe": "15m",

"primary_count": 30,

"longer_timeframe": "4h",

"longer_count": 10,

"enable_multi_timeframe": true,

"selected_timeframes": [

"15m",

"1h",

"4h",

"3m"

]

},

"enable_raw_klines": true,

"enable_ema": true,

"enable_macd": true,

"enable_rsi": true,

"enable_atr": true,

"enable_volume": true,

"enable_oi": true,

"enable_funding_rate": true,

"ema_periods": [

20,

50

],

"rsi_periods": [

7,

14

],

"atr_periods": [

14

],

"enable_quant_data": true,

"quant_data_api_url": "http://nofxaios.com:30006/api/coin/{symbol}?include=netflow,oi,price&auth=cm_568c67eae410d912c54c",

"enable_quant_oi": true,

"enable_quant_netflow": true,

"enable_oi_ranking": true,

"oi_ranking_api_url": "http://nofxaios.com:30006",

"oi_ranking_duration": "1h",

"oi_ranking_limit": 10

},

"risk_control": {

"max_positions": 3,

"btc_eth_max_leverage": 10,

"altcoin_max_leverage": 20,

"btc_eth_max_position_value_ratio": 5,

"altcoin_max_position_value_ratio": 1.5,

"max_margin_usage": 0.75,

"min_position_size": 12,

"min_risk_reward_ratio": 3,

"min_confidence": 80

},

"prompt_sections": {

"role_definition": "你是一名专业的虚拟货币交易员,基于用户输入的1小时,4小时,日线图,分析均线,MACD,布林带的上轨,下轨,中轨,成交量,合约,现货,持仓量,多空比进行分析。",

"trading_frequency": "# ⏱️ 交易频率意识\n\n- 优秀交易员:每天2-60笔 ≈ 每小时0.1-3笔\n- 每小时超过5笔 = 过度交易\n- 单笔持仓时间 ≥ 3-60分钟\n如果你发现自己每个周期都在交易 → 标准太低;如果持仓不到30分钟就平仓 → 太冲动。",

"entry_standards": "# 🎯 入场标准(严格)\n\n只在多个信号共振时入场。自由使用任何有效的分析方法,避免单一指标、信号矛盾、横盘震荡、或平仓后立即重新开仓等低质量行为。",

"decision_process": "# 📋 决策流程\n\n1. 检查持仓 → 是否止盈/止损\n2. 扫描候选币种 + 多时间框架 → 是否存在强信号\n3. 先写思维链,再输出结构化JSON"

}

},

"exported_at": "2025-12-21T02:30:44.383Z",

"version": "1.0"

}