怎样禁止AI抓取网站内容用于其训练?

本文探讨了如何利用robots文件禁止AI抓取网站内容用于训练。通过介绍各大搜索引擎和AI公司的蜘蛛用户代理及其禁用方法,本文旨在帮助站长们保护自己网站的内容。读者将了解目前有效的禁止方法以及未来可能的挑战...

本文探讨了如何利用robots文件禁止AI抓取网站内容用于训练。通过介绍各大搜索引擎和AI公司的蜘蛛用户代理及其禁用方法,本文旨在帮助站长们保护自己网站的内容。读者将了解目前有效的禁止方法以及未来可能的挑战...

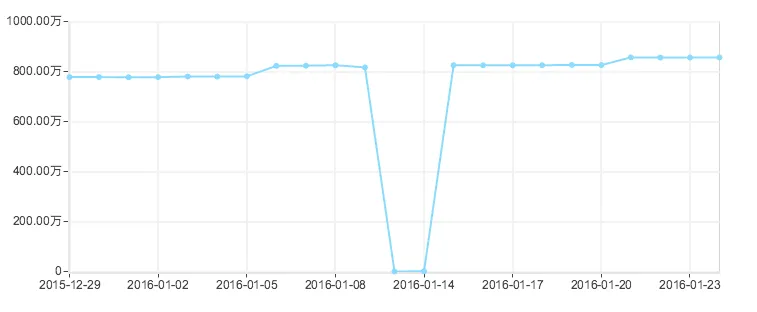

在网站运营的世界里,有时候一个看似微小的错误可以引发巨大的危机。就像漫画中的一颗小石子,当它滚动下山时,可能会引发雪崩,让整个局势失控。今天,我将与大家分享一个真实的故事,讲述了一场紧急救援的经历...

在互联网时代,网站的流量对于许多网站所有者和运营者来说至关重要。流量意味着用户的访问和互动,是网站生存和发展的关键。而搜索引擎则是带来大量流量的主要渠道之一。然而,有时候,我们希望搜索引擎不要访问...