在网站运营的世界里,有时候一个看似微小的错误可以引发巨大的危机。就像漫画中的一颗小石子,当它滚动下山时,可能会引发雪崩,让整个局势失控。今天,我将与大家分享一个真实的故事,讲述了一场紧急救援的经历,当网站的Robots文件被错误封禁时,网站流量骤降800万,关键词大量掉线,我们是如何化险为夷的。

案例背景

故事的主人公是某厦门的网站运营负责人,我们姑且称之为小明。小明的网站正处于快速发展阶段,他们决定进行一次重大的版本迭代,将网站从1.0版本升级到2.0版本。为了保护开发版本不被搜索引擎抓取,技术团队设置了Robots封禁处理,禁止搜索引擎访问开发版本。

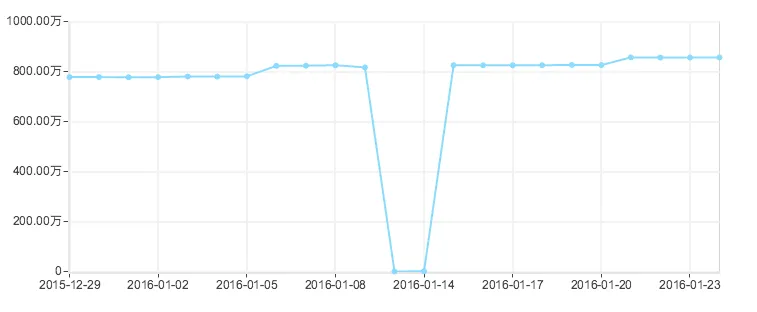

1.0版本的网站非常成功,拥有超过800万的收录页面,关键词排名也相当不错。然而,当2.0版本上线后,网站流量急剧下降,关键词掉线,一切都变得混乱不堪。小明赶紧查看了搜索引擎的收录情况,发现800万的收录页面竟然降至0条!这是一场灾难性的错误,网站的命运似乎悬在了一根线上。

处理方式

小明明白,现在是紧急处理的时候了。他迅速采取了一系列措施,试图挽救网站的流量和排名。

1. 修改Robots封禁为允许

首要任务是修复Robots文件,将封禁改为允许搜索引擎蜘蛛访问网站。技术团队迅速进行了修改,并将Robots文件中的封禁规则全部撤销。

2. 检测并更新Robots

修改Robots文件后,小明需要确保搜索引擎蜘蛛能够及时获取最新的Robots文件内容。他前往百度搜索资源后台,进行了Robots的检测和更新,但发现抓取失败。不过,小明并没有灰心,多次点击抓取请求,试图触发搜索引擎蜘蛛重新访问网站。

3. 申请抓取频次上调

为了让搜索引擎蜘蛛更加频繁地访问网站,小明前往百度搜索资源后台,申请抓取频次的上调。他明白,只有让搜索引擎蜘蛛尽快重新抓取网站,才能恢复流量和排名。

4. 向百度反馈中心求助

小明并不只是在自己的一人世界里奋斗,他知道可以寻求外部的帮助。他联系了百度反馈中心,向他们说明了情况,说明是因为误操作导致了这一问题。虽然不能确定是否会得到帮助,但他觉得这是一种值得尝试的方式。

5. 数据API推送

为了确保搜索引擎蜘蛛及时获取网站的最新数据,小明设置了数据API推送,希望能够实时地将网站内容传输给搜索引擎。

6. 更新sitemap网站地图

最后,为了进一步提高网站的可见性,小明更新了网站的sitemap(站点地图),并重新提交给百度。他决定每天都手动提交一次sitemap,以确保搜索引擎能够及时发现网站的新内容。

等待与复苏

接下来的日子,对于小明和他的团队来说都异常漫长。他们不断关注着网站的流量和收录情况,每天都期待着好消息的到来。

然而,不久之后,好消息终于降临了。在经过了短短两天的时间里,数据开始慢慢回升,关键词重新恢复了排名,网站的流量逐渐回到了正常状态。小明和他的团队松了一口气,他们成功地化险为夷,挽救了网站的命运。

结语

这个真实的故事告诉我们,在网站运营中,Robots文件虽然看似微小,却有着巨大的影响力。一个错误的Robots设置可能导致流量暴跌、排名下滑,甚至对网站的生存造成威胁。因此,无论是站长还是网站运营者,都应该对Robots文件保持警惕,确保其正确配置。同时,当出现问题时,不要轻言放弃,寻求帮助和采取紧急措施,或许能够挽救网站的命运,就像小明一样,化险为夷,最终战胜了Robots的误封禁。