近日,微软德国 CTO Andreas Braun 在一场名为 “AI in Focus – Digital Kickoff” 的活动中宣布,GPT-4 将在下周发布,将提供多模态模型。自 3 月初发布 Kosmos-1 以来,微软正在与 OpenAI 微调多模态这一事实应该不再是一个秘密。

什么是多模态模型

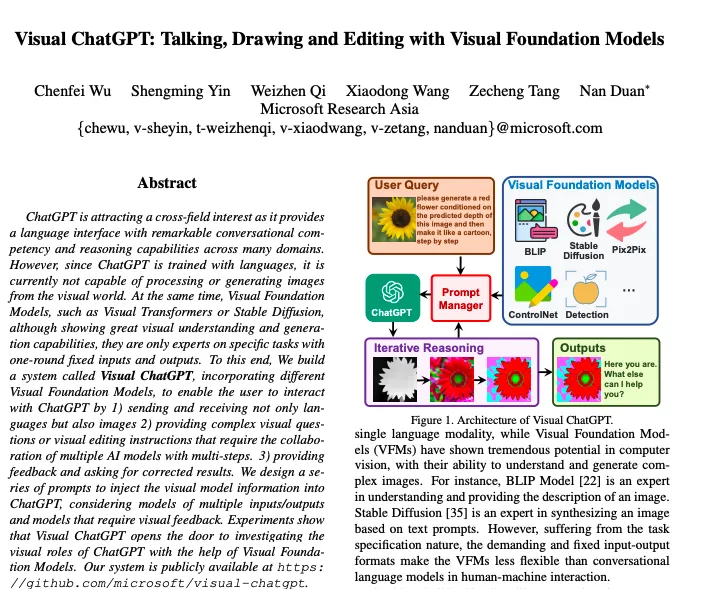

多模态模型是指可以处理多种不同类型数据的模型,例如文本、图像、语音等。与单模态模型相比,多模态模型可以更全面地理解和处理数据,从而提高模型的准确性和效率。GPT-4将提供多模态模型,可处理多种类型的输入和输出,包括文本、图像和视频等,这将带来更具颠覆性的影响。微软也在多模态方向上进行了探索,推出了全能型人工智能模型Kosmos-1和Visual ChatGPT,这些模型可以同时处理文本和图像等多种类型的数据,从而实现更全面的理解和应用。

GPT-4将向多模态方向转变

今年 1 月,OpenAI CEO Sam Altman 在回应 “GPT-4 可能拥有 100 万亿参数” 的说法时,称其为“完全是胡说”。这也暗示了即将到来的 GPT-4 不会一味地扩大参数量,而可能向其他方向寻求提升。而这次的 GPT-4 将转向多模态,未来的输入输出将出现图像、视频等形态,或将在业内产生更具颠覆性的影响。

GPT-4将向多模态方向转变

微软在多模态方向也动作频频,其推出了全能型人工智能模型 Kosmos-1。与局限于文本内容(LLM)的 ChatGPT 相比,Kosmos-1 属于多模态大型语言模型(MLLM),目前能同时理解文字与图像内容,未来会整合更多的输入模式,如音频、视频。

除了 GPT-4 之外,微软也于 3 月 8 日提出了 Visual ChatGPT,其包含不同的视觉基础模型,可以使用户通过以下方式与 ChatGPT 互动:

1)不仅发送和接收语言,而且发送和接收图像;

2)提供复杂的视觉问题或视觉编辑指令,这需要多个人工智能模型的协作和多步骤;

3)提供反馈并要求纠正结果。

GPT-4 究竟会展现出怎样的能力?让我们拭目以待吧。