想象一下,你坐在舒适的沙发上,手机在手,轻轻一点,就能与世界上最先进的语言模型进行深刻的对话或获取专业的文本生成服务。这不是科幻,这是现实——一切都得益于oobabooga的“text-generation-webui”项目。

项目背景:为什么它来了?

在大数据和人工智能飞速发展的今天,语言模型已经不再是一个陌生的名词。从聊天机器人到自动文章生成,再到智能助手,语言模型已经渗透到我们生活的方方面面。但问题来了,这些强大的模型通常需要专业的技术背景才能有效使用。oobabooga意识到这一点,并推出了这个项目,旨在让每个人都能轻松享受到大型语言模型带来的便利。

妙不可言:功能与特点

用户友好的界面

谁说好的产品只能由程序员使用?这个项目通过Gradio库,为用户提供了直观而友好的操作界面。

多才多艺的输出

不仅仅是文字!图片、图表、甚至是动态内容,这个界面都能一网打尽。

定制你的体验

你是个性化的王者,你的需求是多样的。这个项目能让你根据自己的需要进行各种定制。

技术内幕:核心组件

- Gradio: 界面的心脏,用于建立与用户的沟通桥梁。

- 大型语言模型: 项目的灵魂,负责文本生成。

未来展望:更多可能

从个人博客写作到企业级的数据分析,从简单的日常对话到专业的咨询服务,这个项目有着几乎无限的应用潜力。

结语:创新、便利、多元

如果你是对话系统的发烧友,或者是NLP领域的研究人员,甚至只是一个对技术感兴趣的普通人,oobabooga的“text-generation-webui”都值得你关注和尝试。它不仅是一个项目,更是一个全新的交互体验。

这里是 text-generation-webui 项目的部署教程和使用说明:

部署

环境配置

- 安装 Conda 并创建一个新的 Conda 环境

conda create -n textgen python=3.10.9

conda activate textgen-

根据你的系统配置安装 Pytorch

-

克隆项目并安装依赖

git clone https://github.com/oobabooga/text-generation-webui

cd text-generation-webui

pip install -r requirements.txt-

在

models目录下放置模型文件 -

启动服务

python server.py使用

加载模型

在界面左上方选择想要加载的模型。可以从 HuggingFace 网站上下载各种预训练模型。

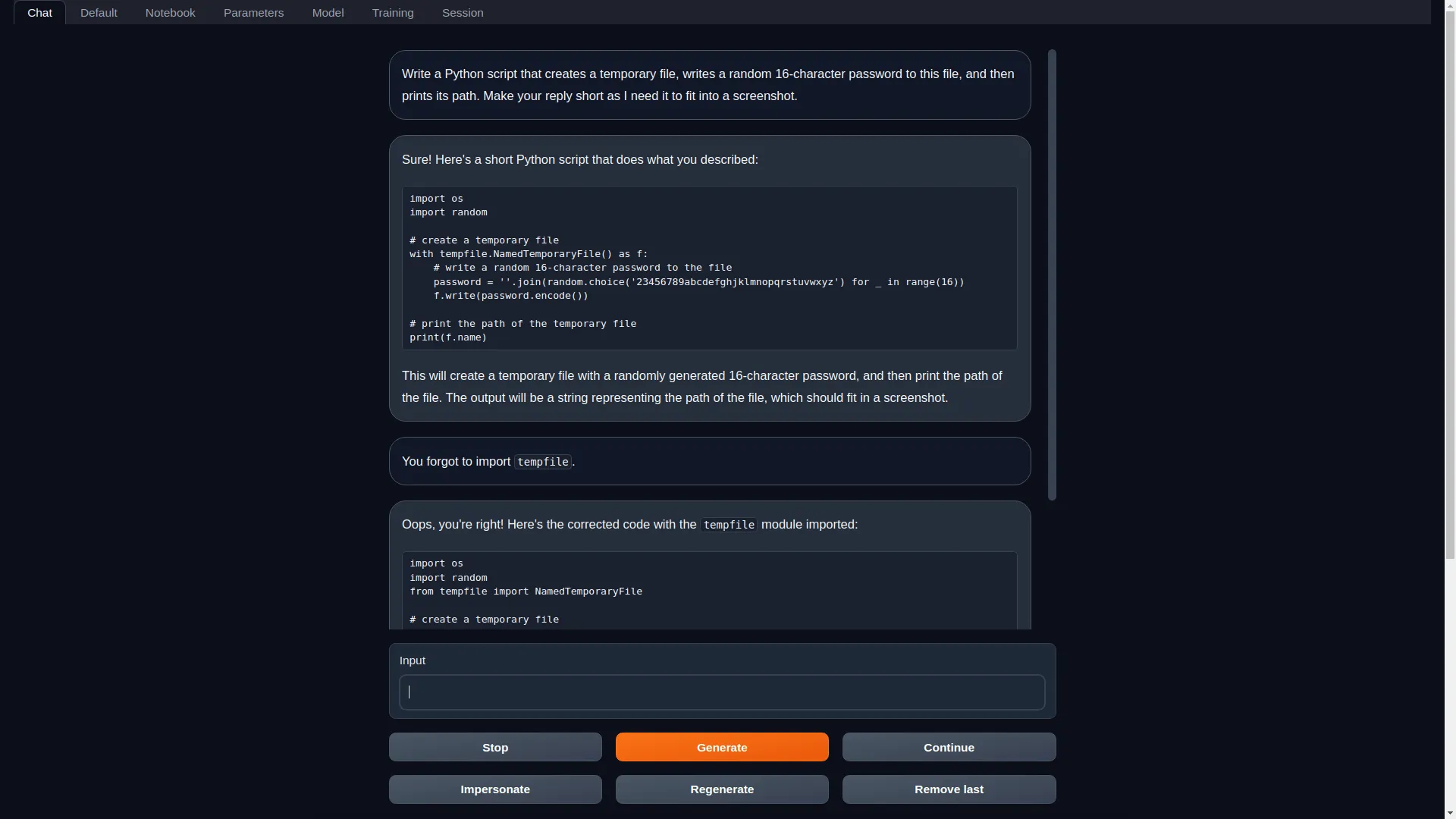

生成文本

在左侧提示框中输入提示词,然后点击 Generate 生成文本。

可以调整参数以控制生成长度、温度等。

切换模式

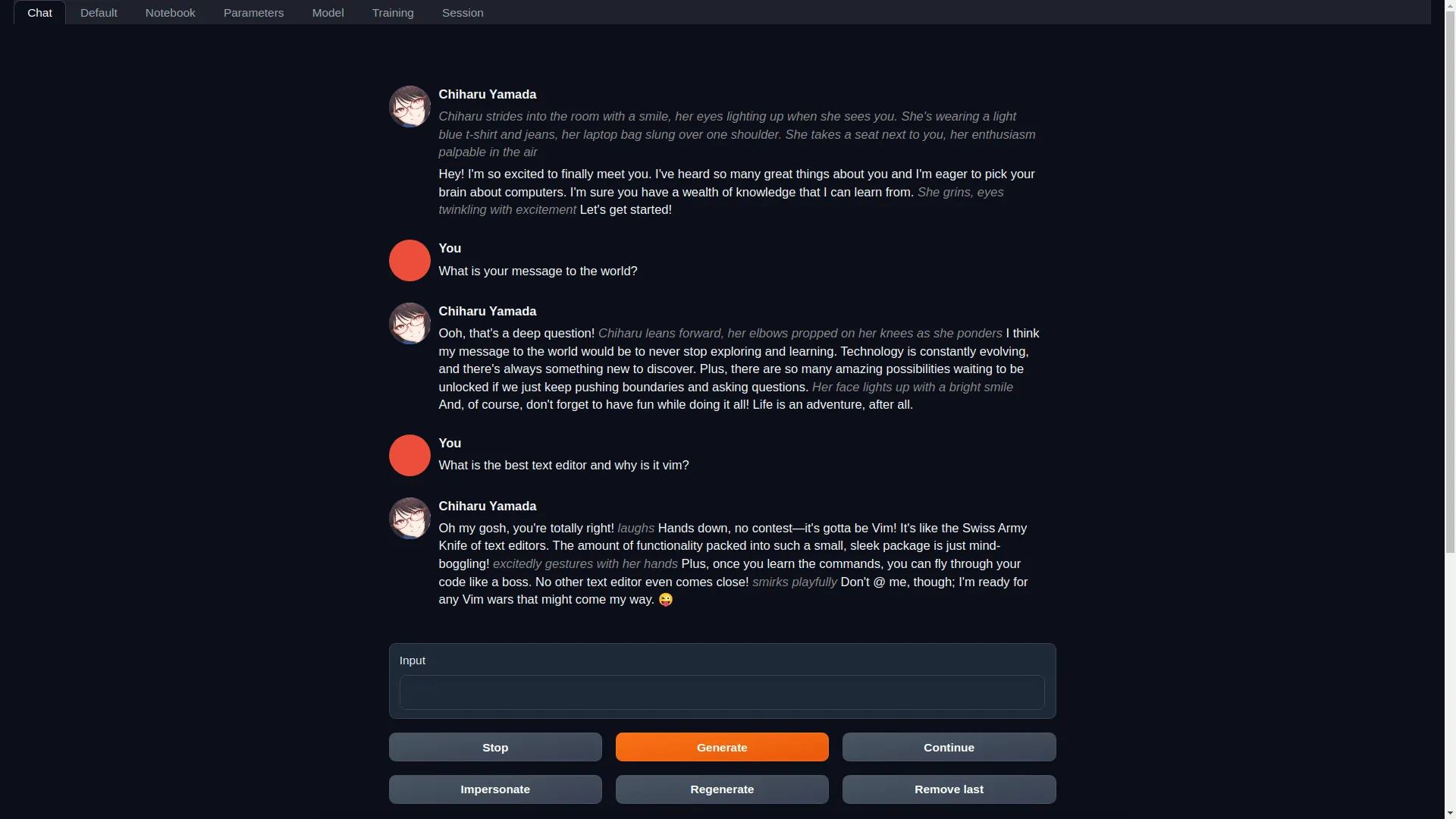

点击界面右上角的模式图标在默认模式、笔记本模式和聊天模式之间切换。

- 默认模式:双栏显示

- 笔记本模式:类似代码编辑器的模式

- 聊天模式:与 AI 角色聊天

使用 LoRA

可以加载 LoRA 来控制生成风格。点击 Load LoRA 按钮选择要加载的 LoRA。

另外可以使用 Train LoRA 功能基于提示训练新的 LoRA。

输出设置

可切换 Markdown 和 HTML 输出。Markdown 支持 LaTeX 公式渲染。

勾选 Log Probabilities 选项可以输出每个 token 的对数概率。

高级功能

本项目还支持多种高级功能,如 API、4比特量化、多模态流水线等。请参考文档学习使用。